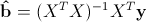

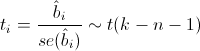

Оценки

коэффициентов множественной линейной

регрессии в матричной форме (2.2)

определяются следующим образом:

.

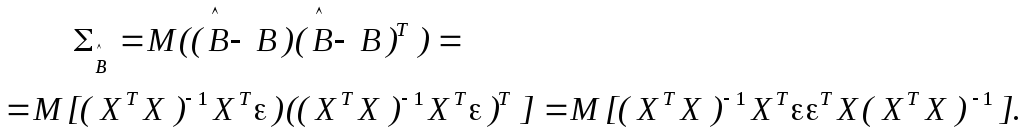

Чтобы

оценить ошибку оценки матрицы коэффициентов

регрессии

подставим в правую часть формулы

теоретические значения объясняемой

переменной:

Таким образом,

ошибка полученной оценки

имеет

вид:

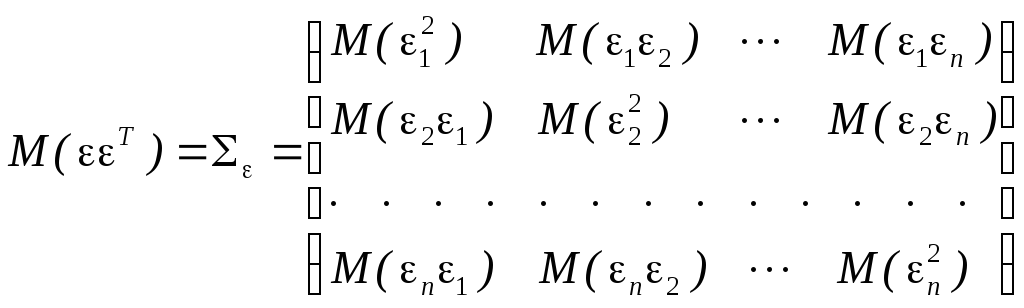

Дисперсия многомерной

случайной величины

определяется с помощью ковариационной

матрицы:

В силу того, что

объясняющие переменные XJ

не являются случайными величинами, их

можно вынести за знак математического

ожидания:

(3.4)

Матрица

представляет собой ковариационную

матрицу неизвестных случайных отклонений

теоретической регрессии:

В силу предпосылки

МНК 2°

все диагональные элементы одинаковы

,

а все остальные равны нулю в силу

предпосылки3°.

Таким образом, ковариационная матрица

случайных ошибок

=

,

а выражение (3.4) принимает следующий

вид:

(3.5)

Неизвестное

значение дисперсии случайного отклонения

теоретической регрессии

заменяется соответствующей несмещенной

выборочной оценкой(3.2). Следовательно, по выборке мы можем

определить только выборочные оценки

дисперсий коэффициентов эмпирической

регрессии

,

которые являются диагональными элементами

матрицы

:

, (3.6)

где через

обозначены диагональные элементы

обратной матрицы,j

= 0, 1, 2, …,

p.

Стандартные

ошибки коэффициентов регрессии

вычисляются по формулам:

, (3.7)

где j

= 0, 1, …, p.

4.3. Доверительные интервалы коэффициентов регрессии

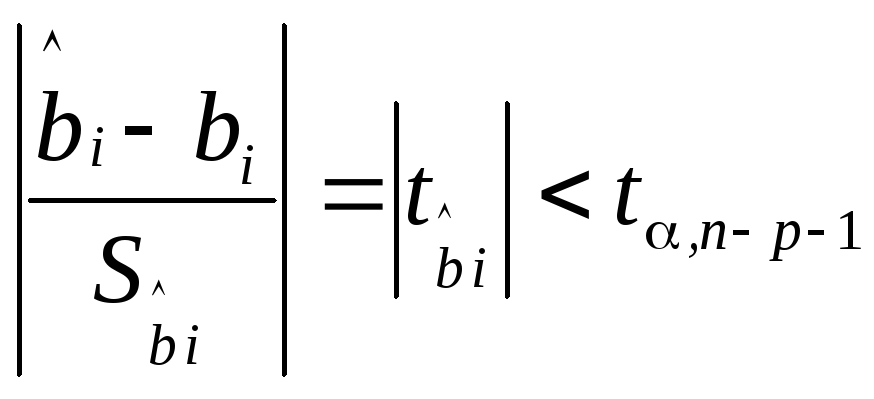

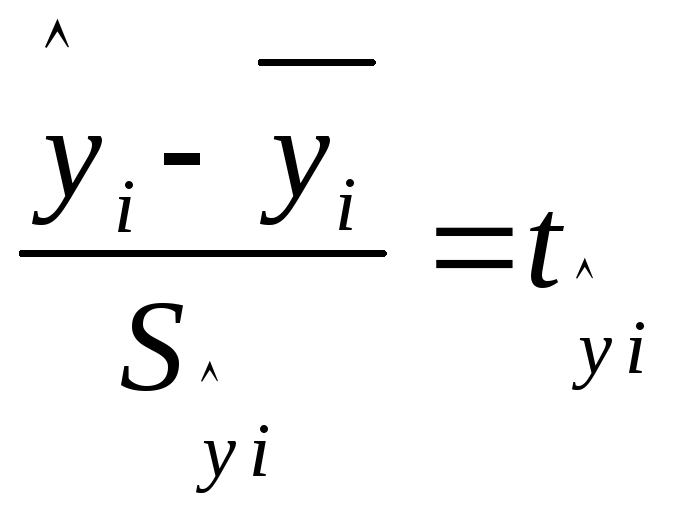

Для построения

интервальной оценки неизвестных

коэффициентов регрессии

вводится случайная величина

регрессии, имеющая распределение

Стьюдента с числом степеней свободы.

При заданном уровне

значимости

доверительный интервал записывается

следующим образом:

где

— табличное значениеt-критерия

Стьюдента

Из данного

неравенства следует:

(3.8)

где

и

— стандартная и предельная ошибки

выборочных оценоксоответственно.

4.4. Стандартная ошибка и доверительные интервалы уравнения регрессии

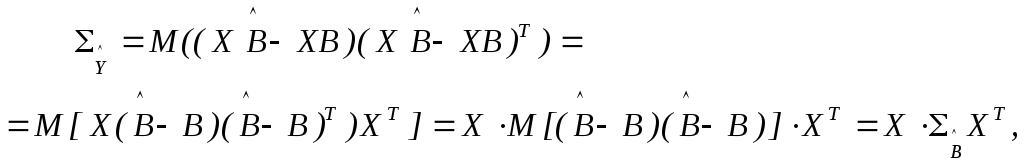

Дисперсия многомерной

случайной величины

определяется с помощью ковариационной

матрицы:

где матрица

определена формулой (3.6).

Таким образом,

получаем окончательное выражение в

матричной форме:

(3.9)

Выборочные оценки

дисперсий i-го

значения эмпирической регрессии

,

соответствующегоi-му

набору значений факторов (1, хi1,

xi2,

…, xip)

в i—ой

строке матрицы Х

исходных данных, располагаются по

диагонали матрицы

:

. (3.10)

Стандартные

ошибки оценок значений регрессии

вычисляются по формулам:

, (3.11)

где i

= 1, 2, …, n.

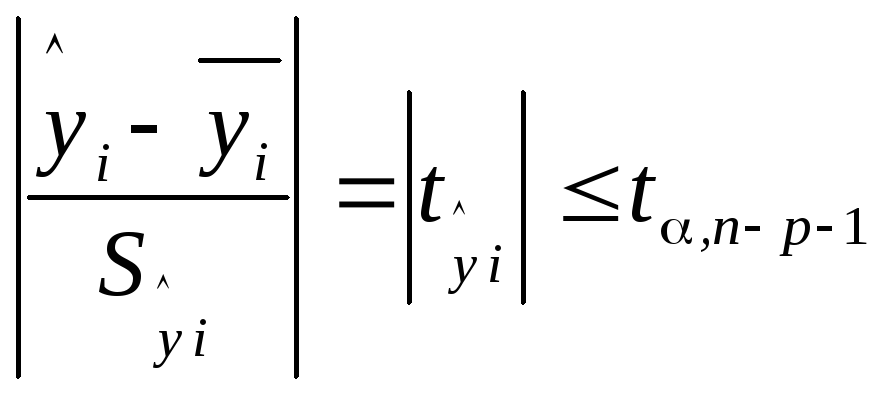

Доверительные

интервалы для неизвестной функции

регрессии

строятся также с помощью случайной

величины

распределение Стьюдента с числом

степеней свободы,i

— номер измерения.

Из данного

неравенства следует:

, (3.12)

где

и

— стандартная и предельная ошибки

расчетного значениясоответственно.

4.5. Статистическая значимость уравнения регрессии

Проверить

статистическую значимость уравнения

множественной регрессии означает

установить, соответствует ли регрессионная

модель, принятая для объяснения

взаимосвязи между переменными, исходным

статистическим данным. Или, другими

словами, достаточно ли включенных в

уравнение регрессии факторов для

описания поведения объясняемой переменной

на основе имеющихся выборочных данных.

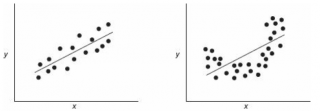

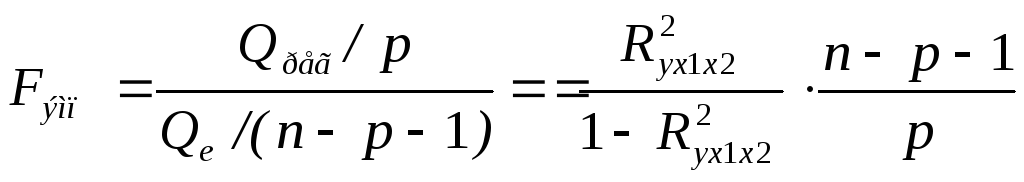

Проверка значимости

уравнения регрессии производится с

помощью метода статистического анализа

– дисперсионного анализа. Оценивание

качества уравнения регрессии с помощью

F-критерия

Фишера состоит в проверке гипотезы H0

о статистической значимости уравнения

регрессии или показателя тесноты связи.

В случае, когда нулевая гипотеза

отвергается, влияние включенных в

регрессию факторов на объясняемую

переменную преобладает над ее изменениями

в силу других причин.

Для этого сравнивают

фактическое значение критерия

с критическим, табличным значением

.

где

— число объясняющих переменных, или

факторов, включенных в модель.

,

где

— уровень значимости;

и

— число степеней свободы большей

(числителя) и меньшей (знаменателя)

дисперсий соответственно.

Если

,

то гипотезаH0

о случайной

природе статистической связи отклоняется.

С вероятностью (

1-

) делается

заключение о статистической значимости

уравнения регрессии в целом и показателя

тесноты связи

,

которые сформировались под совместным

воздействием факторовХ1

и Х2,

которое нет оснований считать случайным.

В противном случае оснований для

отклонения гипотезы

H0

нет и данная

статистическая связь статистически

незначима.

Соседние файлы в предмете [НЕСОРТИРОВАННОЕ]

- #

- #

- #

- #

- #

- #

- #

- #

- #

- #

- #

Когда мы подгоняем регрессионную модель к набору данных, нас часто интересует, насколько хорошо регрессионная модель «подходит» к набору данных. Две метрики, обычно используемые для измерения согласия, включают R -квадрат (R2) и стандартную ошибку регрессии , часто обозначаемую как S.

В этом руководстве объясняется, как интерпретировать стандартную ошибку регрессии (S), а также почему она может предоставить более полезную информацию, чем R 2 .

Стандартная ошибка по сравнению с R-квадратом в регрессии

Предположим, у нас есть простой набор данных, который показывает, сколько часов 12 студентов занимались в день в течение месяца, предшествующего важному экзамену, а также их баллы за экзамен:

Если мы подгоним простую модель линейной регрессии к этому набору данных в Excel, мы получим следующий результат:

R-квадрат — это доля дисперсии переменной отклика, которая может быть объяснена предикторной переменной. При этом 65,76% дисперсии экзаменационных баллов можно объяснить количеством часов, потраченных на учебу.

Стандартная ошибка регрессии — это среднее расстояние, на которое наблюдаемые значения отклоняются от линии регрессии. В этом случае наблюдаемые значения отклоняются от линии регрессии в среднем на 4,89 единицы.

Если мы нанесем фактические точки данных вместе с линией регрессии, мы сможем увидеть это более четко:

Обратите внимание, что некоторые наблюдения попадают очень близко к линии регрессии, в то время как другие не так близки. Но в среднем наблюдаемые значения отклоняются от линии регрессии на 4,19 единицы .

Стандартная ошибка регрессии особенно полезна, поскольку ее можно использовать для оценки точности прогнозов. Примерно 95% наблюдений должны находиться в пределах +/- двух стандартных ошибок регрессии, что является быстрым приближением к 95% интервалу прогнозирования.

Если мы заинтересованы в прогнозировании с использованием модели регрессии, стандартная ошибка регрессии может быть более полезной метрикой, чем R-квадрат, потому что она дает нам представление о том, насколько точными будут наши прогнозы в единицах измерения.

Чтобы проиллюстрировать, почему стандартная ошибка регрессии может быть более полезной метрикой для оценки «соответствия» модели, рассмотрим другой пример набора данных, который показывает, сколько часов 12 студентов занимались в день в течение месяца, предшествующего важному экзамену, а также их экзаменационная оценка:

Обратите внимание, что это точно такой же набор данных, как и раньше, за исключением того, что все значения s сокращены вдвое.Таким образом, студенты из этого набора данных учились ровно в два раза дольше, чем студенты из предыдущего набора данных, и получили ровно половину экзаменационного балла.

Если мы подгоним простую модель линейной регрессии к этому набору данных в Excel, мы получим следующий результат:

Обратите внимание, что R-квадрат 65,76% точно такой же, как и в предыдущем примере.

Однако стандартная ошибка регрессии составляет 2,095 , что ровно вдвое меньше стандартной ошибки регрессии в предыдущем примере.

Если мы нанесем фактические точки данных вместе с линией регрессии, мы сможем увидеть это более четко:

Обратите внимание на то, что наблюдения располагаются гораздо плотнее вокруг линии регрессии. В среднем наблюдаемые значения отклоняются от линии регрессии на 2,095 единицы .

Таким образом, несмотря на то, что обе модели регрессии имеют R-квадрат 65,76% , мы знаем, что вторая модель будет давать более точные прогнозы, поскольку она имеет более низкую стандартную ошибку регрессии.

Преимущества использования стандартной ошибки

Стандартную ошибку регрессии (S) часто бывает полезнее знать, чем R-квадрат модели, потому что она дает нам фактические единицы измерения. Если мы заинтересованы в использовании регрессионной модели для получения прогнозов, S может очень легко сказать нам, достаточно ли точна модель для прогнозирования.

Например, предположим, что мы хотим создать 95-процентный интервал прогнозирования, в котором мы можем прогнозировать результаты экзаменов с точностью до 6 баллов от фактической оценки.

Наша первая модель имеет R-квадрат 65,76%, но это ничего не говорит нам о том, насколько точным будет наш интервал прогнозирования. К счастью, мы также знаем, что у первой модели показатель S равен 4,19. Это означает, что 95-процентный интервал прогнозирования будет иметь ширину примерно 2*4,19 = +/- 8,38 единиц, что слишком велико для нашего интервала прогнозирования.

Наша вторая модель также имеет R-квадрат 65,76%, но опять же это ничего не говорит нам о том, насколько точным будет наш интервал прогнозирования. Однако мы знаем, что вторая модель имеет S 2,095. Это означает, что 95-процентный интервал прогнозирования будет иметь ширину примерно 2*2,095= +/- 4,19 единиц, что меньше 6 и, следовательно, будет достаточно точным для использования для создания интервалов прогнозирования.

Дальнейшее чтение

Введение в простую линейную регрессию

Что такое хорошее значение R-квадрата?

Регрессия позволяет прогнозировать зависимую переменную на основании значений фактора. В

MS

EXCEL

имеется множество функций, которые возвращают не только наклон и сдвиг линии регрессии, характеризующей линейную взаимосвязь между факторами, но и регрессионную статистику. Здесь рассмотрим простую линейную регрессию, т.е. прогнозирование на основе одного фактора.

Disclaimer

: Данную статью не стоит рассматривать, как пересказ главы из учебника по статистике. Статья не обладает ни полнотой, ни строгостью изложения положений статистической науки. Эта статья – о применении MS EXCEL для целей

Регрессионного анализа.

Теоретические отступления приведены лишь из соображения логики изложения. Использование данной статьи для изучения

Регрессии

– плохая идея.

Статья про

Регрессионный анализ

получилась большая, поэтому ниже для удобства приведены ее разделы:

- Немного теории и основные понятия

- Предположения линейной регрессионной модели

- Задачи регрессионного анализа

- Оценка неизвестных параметров линейной модели (используя функции MS EXCEL)

- Оценка неизвестных параметров линейной модели (через статистики выборок)

- Оценка неизвестных параметров линейной модели (матричная форма)

- Построение линии регрессии

- Коэффициент детерминации

- Стандартная ошибка регрессии

- Стандартные ошибки и доверительные интервалы для наклона и сдвига

- Проверка значимости взаимосвязи переменных

- Доверительные интервалы для нового наблюдения Y и среднего значения

- Проверка адекватности линейной регрессионной модели

Примечание

: Если прогнозирование переменной осуществляется на основе нескольких факторов, то имеет место

множественная регрессия

.

Чтобы разобраться, чем может помочь MS EXCEL при проведении регрессионного анализа, напомним вкратце теорию, введем термины и обозначения, которые могут отличаться в зависимости от различных источников.

Примечание

: Для тех, кому некогда, незачем или просто не хочется разбираться в теоретических выкладках предлагается сразу перейти к вычислительной части —

оценке неизвестных параметров линейной модели

.

Немного теории и основные понятия

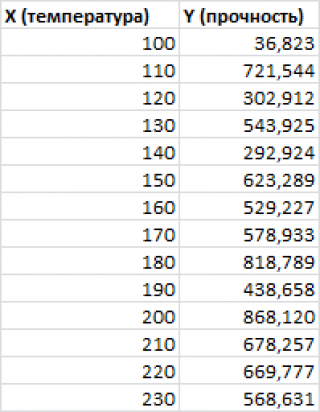

Пусть у нас есть массив данных, представляющий собой значения двух переменных Х и Y. Причем значения переменной Х мы можем произвольно задавать (контролировать) и использовать эту переменную для предсказания значений зависимой переменной Y. Таким образом, случайной величиной является только переменная Y.

Примером такой задачи может быть производственный процесс изготовления некого волокна, причем

прочность этого волокна

(Y) зависит только от

рабочей температуры процесса

в реакторе (Х), которая задается оператором.

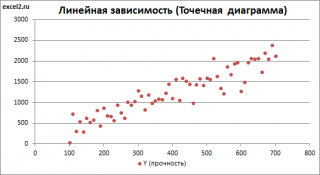

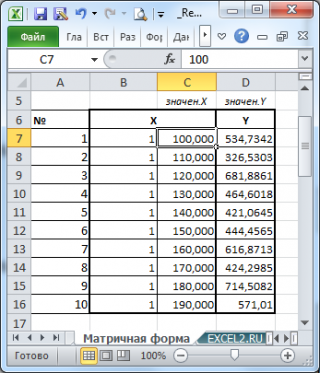

Построим

диаграмму рассеяния

(см.

файл примера лист Линейный

), созданию которой

посвящена отдельная статья

. Вообще, построение

диаграммы рассеяния

для целей

регрессионного анализа

де-факто является стандартом.

СОВЕТ

: Подробнее о построении различных типов диаграмм см. статьи

Основы построения диаграмм

и

Основные типы диаграмм

.

Приведенная выше

диаграмма рассеяния

свидетельствует о возможной

линейной взаимосвязи

между Y от Х: очевидно, что точки данных в основном располагаются вдоль прямой линии.

Примечание

: Наличие даже такой очевидной

линейной взаимосвязи

не может являться доказательством о наличии причинной взаимосвязи переменных. Наличие

причинной

взаимосвязи не может быть доказано на основании только анализа имеющихся измерений, а должно быть обосновано с помощью других исследований, например теоретических выкладок.

Примечание

: Как известно, уравнение прямой линии имеет вид

Y

=

m

*

X

+

k

, где коэффициент

m

отвечает за наклон линии (

slope

),

k

– за сдвиг линии по вертикали (

intercept

),

k

равно значению Y при Х=0.

Предположим, что мы можем зафиксировать переменную Х (

рабочую температуру процесса

) при некотором значении Х

i

и произвести несколько наблюдений переменной Y (

прочность нити

). Очевидно, что при одном и том же значении Хi мы получим различные значения Y. Это обусловлено влиянием других факторов на Y. Например, локальные колебания давления в реакторе, концентрации раствора, наличие ошибок измерения и др. Предполагается, что воздействие этих факторов имеет случайную природу и для каждого измерения имеются одинаковые условия проведения эксперимента (т.е. другие факторы не изменяются).

Полученные значения Y, при заданном Хi, будут колебаться вокруг некого

значения

. При увеличении количества измерений, среднее этих измерений, будет стремиться к

математическому ожиданию

случайной величины Y (при Х

i

) равному μy(i)=Е(Y

i

).

Подобные рассуждения можно привести для любого значения Хi.

Чтобы двинуться дальше, воспользуемся материалом из раздела

Проверка статистических гипотез

. В статье о

проверке гипотезы о среднем значении генеральной совокупности

в качестве

нулевой

гипотезы

предполагалось равенство неизвестного значения μ заданному μ0.

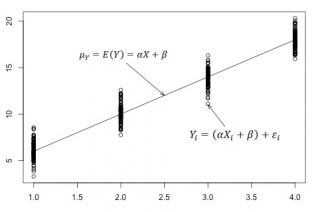

В нашем случае

простой линейной регрессии

в качестве

нулевой

гипотезы

предположим, что между переменными μy(i) и Хi существует линейная взаимосвязь μ

y(i)

=α* Х

i

+β. Уравнение μ

y(i)

=α* Х

i

+β можно переписать в обобщенном виде (для всех Х и μ

y

) как μ

y

=α* Х +β.

Для наглядности проведем прямую линию соединяющую все μy(i).

Данная линия называется

регрессионной линией генеральной совокупности

(population regression line), параметры которой (

наклон

a и

сдвиг β

) нам не известны (по аналогии с

гипотезой о среднем значении генеральной совокупности

, где нам было неизвестно истинное значение μ).

Теперь сделаем переход от нашего предположения, что μy=a* Х +

β

, к предсказанию значения случайной переменной Y в зависимости от значения контролируемой переменной Х. Для этого уравнение связи двух переменных запишем в виде Y=a*X+β+ε, где ε — случайная ошибка, которая отражает суммарный эффект влияния других факторов на Y (эти «другие» факторы не участвуют в нашей модели). Напомним, что т.к. переменная Х фиксирована, то ошибка ε определяется только свойствами переменной Y.

Уравнение Y=a*X+b+ε называют

линейной регрессионной моделью

. Часто Х еще называют

независимой переменной

(еще

предиктором

и

регрессором

, английский термин

predictor

,

regressor

), а Y –

зависимой

(или

объясняемой

,

response

variable

). Так как

регрессор

у нас один, то такая модель называется

простой линейной регрессионной моделью

(

simple

linear

regression

model

). α часто называют

коэффициентом регрессии.

Предположения линейной регрессионной модели перечислены в следующем разделе.

Предположения линейной регрессионной модели

Чтобы модель линейной регрессии Yi=a*Xi+β+ε

i

была адекватной — требуется:

-

Ошибки ε

i

должны быть независимыми переменными; -

При каждом значении Xi ошибки ε

i

должны быть иметь нормальное распределение (также предполагается равенство нулю математического ожидания, т.е. Е[ε

i

]=0); -

При каждом значении Xi ошибки ε

i

должны иметь равные дисперсии (обозначим ее σ

2

).

Примечание

: Последнее условие называется

гомоскедастичность

— стабильность, гомогенность дисперсии случайной ошибки e. Т.е.

дисперсия

ошибки σ

2

не должна зависеть от значения Xi.

Используя предположение о равенстве математического ожидания Е[ε

i

]=0 покажем, что μy(i)=Е[Yi]:

Е[Yi]= Е[a*Xi+β+ε

i

]= Е[a*Xi+β]+ Е[ε

i

]= a*Xi+β= μy(i), т.к. a, Xi и β постоянные значения.

Дисперсия

случайной переменной Y равна

дисперсии

ошибки ε, т.е. VAR(Y)= VAR(ε)=σ

2

. Это является следствием, что все значения переменной Х являются const, а VAR(ε)=VAR(ε

i

).

Задачи регрессионного анализа

Для проверки гипотезы о линейной взаимосвязи переменной Y от X делают выборку из генеральной совокупности (этой совокупности соответствует

регрессионная линия генеральной совокупности

, т.е. μy=a* Х +β). Выборка будет состоять из n точек, т.е. из n пар значений {X;Y}.

На основании этой выборки мы можем вычислить оценки наклона a и сдвига β, которые обозначим соответственно

a

и

b

. Также часто используются обозначения â и b̂.

Далее, используя эти оценки, мы также можем проверить гипотезу: имеется ли линейная связь между X и Y статистически значимой?

Таким образом:

Первая задача

регрессионного анализа

– оценка неизвестных параметров (

estimation

of

the

unknown

parameters

). Подробнее см. раздел

Оценки неизвестных параметров модели

.

Вторая задача

регрессионного анализа

–

Проверка адекватности модели

(

model

adequacy

checking

).

Примечание

: Оценки параметров модели обычно вычисляются

методом наименьших квадратов

(МНК),

которому посвящена отдельная статья

.

Оценка неизвестных параметров линейной модели (используя функции MS EXCEL)

Неизвестные параметры

простой линейной регрессионной модели

Y=a*X+β+ε оценим с помощью

метода наименьших квадратов

(в

статье про МНК подробно описано этот метод

).

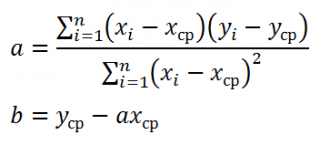

Для вычисления параметров линейной модели методом МНК получены следующие выражения:

Таким образом, мы получим уравнение прямой линии Y=

a

*X+

b

, которая наилучшим образом аппроксимирует имеющиеся данные.

Примечание

: В статье про

метод наименьших квадратов

рассмотрены случаи аппроксимации

линейной

и

квадратичной функцией

, а также

степенной

,

логарифмической

и

экспоненциальной функцией

.

Оценку параметров в MS EXCEL можно выполнить различными способами:

-

с помощью функций

НАКЛОН()

и

ОТРЕЗОК()

; -

с помощью функции

ЛИНЕЙН()

; см. статьюФункция MS EXCEL ЛИНЕЙН()

-

формулами через статистики выборок

;

-

в матричной форме

;

-

с помощью

инструмента Регрессия надстройки Пакет Анализа

.

Сначала рассмотрим функции

НАКЛОН()

,

ОТРЕЗОК()

и

ЛИНЕЙН()

.

Пусть значения Х и Y находятся соответственно в диапазонах

C

23:

C

83

и

B

23:

B

83

(см.

файл примера

внизу статьи).

Примечание

: Значения двух переменных Х и Y можно сгенерировать, задав тренд и величину случайного разброса (см. статью

Генерация данных для линейной регрессии в MS EXCEL

).

В MS EXCEL наклон прямой линии

а

(

оценку

коэффициента регрессии

), можно найти по

методу МНК

с помощью функции

НАКЛОН()

, а сдвиг

b

(

оценку

постоянного члена

или

константы регрессии

), с помощью функции

ОТРЕЗОК()

. В английской версии это функции SLOPE и INTERCEPT соответственно.

Аналогичный результат можно получить с помощью функции

ЛИНЕЙН()

, английская версия LINEST (см.

статью об этой функции

).

Формула

=ЛИНЕЙН(C23:C83;B23:B83)

вернет наклон

а

. А формула =

ИНДЕКС(ЛИНЕЙН(C23:C83;B23:B83);2)

— сдвиг

b

. Здесь требуются пояснения.

Функция

ЛИНЕЙН()

имеет 4 аргумента и возвращает целый массив значений:

ЛИНЕЙН(известные_значения_y; [известные_значения_x]; [конст]; [статистика])

Если 4-й аргумент

статистика

имеет значение ЛОЖЬ или опущен, то функция

ЛИНЕЙН()

возвращает только оценки параметров модели:

a

и

b

.

Примечание

: Остальные значения, возвращаемые функцией

ЛИНЕЙН()

, нам потребуются при вычислении

стандартных ошибок

и для

проверки значимости регрессии

. В этом случае аргумент

статистика

должен иметь значение ИСТИНА.

Чтобы вывести сразу обе оценки:

- в одной строке необходимо выделить 2 ячейки,

-

ввести формулу в

Строке формул

-

нажать

CTRL

+

SHIFT

+

ENTER

(см. статью проформулы массива

).

Если в

Строке формул

выделить формулу =

ЛИНЕЙН(C23:C83;B23:B83)

и нажать

клавишу F9

, то мы увидим что-то типа {3,01279389265416;154,240057900613}. Это как раз значения

a

и

b

. Как видно, оба значения разделены точкой с запятой «;», что свидетельствует, что функция вернула значения «в нескольких ячейках одной строки».

Если требуется вывести параметры линии не в одной строке, а одном столбце (ячейки друг под другом), то используйте формулу =

ТРАНСП(ЛИНЕЙН(C23:C83;B23:B83))

. При этом выделять нужно 2 ячейки в одном столбце. Если теперь выделить новую формулу и нажать клавишу F9, то мы увидим что 2 значения разделены двоеточием «:», что означает, что значения выведены в столбец (функция

ТРАНСП()

транспонировала строку в столбец

).

Чтобы разобраться в этом подробнее необходимо ознакомиться с

формулами массива

.

Чтобы не связываться с вводом

формул массива

, можно

использовать функцию ИНДЕКС()

. Формула =

ИНДЕКС(ЛИНЕЙН(C23:C83;B23:B83);1)

или просто

ЛИНЕЙН(C23:C83;B23:B83)

вернет параметр, отвечающий за наклон линии, т.е.

а

. Формула

=ИНДЕКС(ЛИНЕЙН(C23:C83;B23:B83);2)

вернет параметр

b

.

Оценка неизвестных параметров линейной модели (через статистики выборок)

Наклон линии, т.е. коэффициент

а

, можно также вычислить через

коэффициент корреляции

и

стандартные отклонения выборок

:

=

КОРРЕЛ(B23:B83;C23:C83) *(СТАНДОТКЛОН.В(C23:C83)/ СТАНДОТКЛОН.В(B23:B83))

Вышеуказанная формула математически эквивалентна отношению

ковариации

выборок Х и Y и

дисперсии

выборки Х:

=

КОВАРИАЦИЯ.В(B23:B83;C23:C83)/ДИСП.В(B23:B83)

И, наконец, запишем еще одну формулу для нахождения сдвига

b

. Воспользуемся тем фактом, что

линия регрессии

проходит через точку

средних значений

переменных Х и Y.

Вычислив

средние значения

и подставив в формулу ранее найденный наклон

а

, получим сдвиг

b

.

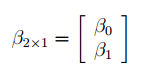

Оценка неизвестных параметров линейной модели (матричная форма)

Также параметры

линии регрессии

можно найти в матричной форме (см.

файл примера лист Матричная форма

).

В формуле символом β обозначен столбец с искомыми параметрами модели: β0 (сдвиг

b

), β1 (наклон

a

).

Построим

диаграмму рассеяния

(см.

файл примера лист Линейный

), созданию которой

посвящена отдельная статья

. Вообще, построение

диаграммы рассеяния

для целей

регрессионного анализа

де-факто является стандартом.

СОВЕТ

: Подробнее о построении различных типов диаграмм см. статьи

Основы построения диаграмм

и

Основные типы диаграмм

.

Приведенная выше

диаграмма рассеяния

свидетельствует о возможной

линейной взаимосвязи

между Y от Х: очевидно, что точки данных в основном располагаются вдоль прямой линии.

Примечание

: Наличие даже такой очевидной

линейной взаимосвязи

не может являться доказательством о наличии причинной взаимосвязи переменных. Наличие

причинной

взаимосвязи не может быть доказано на основании только анализа имеющихся измерений, а должно быть обосновано с помощью других исследований, например теоретических выкладок.

Примечание

: Как известно, уравнение прямой линии имеет вид

Y

=

m

*

X

+

k

, где коэффициент

m

отвечает за наклон линии (

slope

),

k

– за сдвиг линии по вертикали (

intercept

),

k

равно значению Y при Х=0.

Предположим, что мы можем зафиксировать переменную Х (

рабочую температуру процесса

) при некотором значении Х

i

и произвести несколько наблюдений переменной Y (

прочность нити

). Очевидно, что при одном и том же значении Хi мы получим различные значения Y. Это обусловлено влиянием других факторов на Y. Например, локальные колебания давления в реакторе, концентрации раствора, наличие ошибок измерения и др. Предполагается, что воздействие этих факторов имеет случайную природу и для каждого измерения имеются одинаковые условия проведения эксперимента (т.е. другие факторы не изменяются).

Полученные значения Y, при заданном Хi, будут колебаться вокруг некого

значения

. При увеличении количества измерений, среднее этих измерений, будет стремиться к

математическому ожиданию

случайной величины Y (при Х

i

) равному μy(i)=Е(Y

i

).

Подобные рассуждения можно привести для любого значения Хi.

Чтобы двинуться дальше, воспользуемся материалом из раздела

Проверка статистических гипотез

. В статье о

проверке гипотезы о среднем значении генеральной совокупности

в качестве

нулевой

гипотезы

предполагалось равенство неизвестного значения μ заданному μ0.

В нашем случае

простой линейной регрессии

в качестве

нулевой

гипотезы

предположим, что между переменными μy(i) и Хi существует линейная взаимосвязь μ

y(i)

=α* Х

i

+β. Уравнение μ

y(i)

=α* Х

i

+β можно переписать в обобщенном виде (для всех Х и μ

y

) как μ

y

=α* Х +β.

Для наглядности проведем прямую линию соединяющую все μy(i).

Данная линия называется

регрессионной линией генеральной совокупности

(population regression line), параметры которой (

наклон

a и

сдвиг β

) нам не известны (по аналогии с

гипотезой о среднем значении генеральной совокупности

, где нам было неизвестно истинное значение μ).

Теперь сделаем переход от нашего предположения, что μy=a* Х +

β

, к предсказанию значения случайной переменной Y в зависимости от значения контролируемой переменной Х. Для этого уравнение связи двух переменных запишем в виде Y=a*X+β+ε, где ε — случайная ошибка, которая отражает суммарный эффект влияния других факторов на Y (эти «другие» факторы не участвуют в нашей модели). Напомним, что т.к. переменная Х фиксирована, то ошибка ε определяется только свойствами переменной Y.

Уравнение Y=a*X+b+ε называют

линейной регрессионной моделью

. Часто Х еще называют

независимой переменной

(еще

предиктором

и

регрессором

, английский термин

predictor

,

regressor

), а Y –

зависимой

(или

объясняемой

,

response

variable

). Так как

регрессор

у нас один, то такая модель называется

простой линейной регрессионной моделью

(

simple

linear

regression

model

). α часто называют

коэффициентом регрессии.

Предположения линейной регрессионной модели перечислены в следующем разделе.

Предположения линейной регрессионной модели

Чтобы модель линейной регрессии Yi=a*Xi+β+ε

i

была адекватной — требуется:

-

Ошибки ε

i

должны быть независимыми переменными; -

При каждом значении Xi ошибки ε

i

должны быть иметь нормальное распределение (также предполагается равенство нулю математического ожидания, т.е. Е[ε

i

]=0); -

При каждом значении Xi ошибки ε

i

должны иметь равные дисперсии (обозначим ее σ

2

).

Примечание

: Последнее условие называется

гомоскедастичность

— стабильность, гомогенность дисперсии случайной ошибки e. Т.е.

дисперсия

ошибки σ

2

не должна зависеть от значения Xi.

Используя предположение о равенстве математического ожидания Е[ε

i

]=0 покажем, что μy(i)=Е[Yi]:

Е[Yi]= Е[a*Xi+β+ε

i

]= Е[a*Xi+β]+ Е[ε

i

]= a*Xi+β= μy(i), т.к. a, Xi и β постоянные значения.

Дисперсия

случайной переменной Y равна

дисперсии

ошибки ε, т.е. VAR(Y)= VAR(ε)=σ

2

. Это является следствием, что все значения переменной Х являются const, а VAR(ε)=VAR(ε

i

).

Задачи регрессионного анализа

Для проверки гипотезы о линейной взаимосвязи переменной Y от X делают выборку из генеральной совокупности (этой совокупности соответствует

регрессионная линия генеральной совокупности

, т.е. μy=a* Х +β). Выборка будет состоять из n точек, т.е. из n пар значений {X;Y}.

На основании этой выборки мы можем вычислить оценки наклона a и сдвига β, которые обозначим соответственно

a

и

b

. Также часто используются обозначения â и b̂.

Далее, используя эти оценки, мы также можем проверить гипотезу: имеется ли линейная связь между X и Y статистически значимой?

Таким образом:

Первая задача

регрессионного анализа

– оценка неизвестных параметров (

estimation

of

the

unknown

parameters

). Подробнее см. раздел

Оценки неизвестных параметров модели

.

Вторая задача

регрессионного анализа

–

Проверка адекватности модели

(

model

adequacy

checking

).

Примечание

: Оценки параметров модели обычно вычисляются

методом наименьших квадратов

(МНК),

которому посвящена отдельная статья

.

Оценка неизвестных параметров линейной модели (используя функции MS EXCEL)

Неизвестные параметры

простой линейной регрессионной модели

Y=a*X+β+ε оценим с помощью

метода наименьших квадратов

(в

статье про МНК подробно описано этот метод

).

Для вычисления параметров линейной модели методом МНК получены следующие выражения:

Таким образом, мы получим уравнение прямой линии Y=

a

*X+

b

, которая наилучшим образом аппроксимирует имеющиеся данные.

Примечание

: В статье про

метод наименьших квадратов

рассмотрены случаи аппроксимации

линейной

и

квадратичной функцией

, а также

степенной

,

логарифмической

и

экспоненциальной функцией

.

Оценку параметров в MS EXCEL можно выполнить различными способами:

-

с помощью функций

НАКЛОН()

и

ОТРЕЗОК()

; -

с помощью функции

ЛИНЕЙН()

; см. статьюФункция MS EXCEL ЛИНЕЙН()

-

формулами через статистики выборок

;

-

в матричной форме

;

-

с помощью

инструмента Регрессия надстройки Пакет Анализа

.

Сначала рассмотрим функции

НАКЛОН()

,

ОТРЕЗОК()

и

ЛИНЕЙН()

.

Пусть значения Х и Y находятся соответственно в диапазонах

C

23:

C

83

и

B

23:

B

83

(см.

файл примера

внизу статьи).

Примечание

: Значения двух переменных Х и Y можно сгенерировать, задав тренд и величину случайного разброса (см. статью

Генерация данных для линейной регрессии в MS EXCEL

).

В MS EXCEL наклон прямой линии

а

(

оценку

коэффициента регрессии

), можно найти по

методу МНК

с помощью функции

НАКЛОН()

, а сдвиг

b

(

оценку

постоянного члена

или

константы регрессии

), с помощью функции

ОТРЕЗОК()

. В английской версии это функции SLOPE и INTERCEPT соответственно.

Аналогичный результат можно получить с помощью функции

ЛИНЕЙН()

, английская версия LINEST (см.

статью об этой функции

).

Формула

=ЛИНЕЙН(C23:C83;B23:B83)

вернет наклон

а

. А формула =

ИНДЕКС(ЛИНЕЙН(C23:C83;B23:B83);2)

— сдвиг

b

. Здесь требуются пояснения.

Функция

ЛИНЕЙН()

имеет 4 аргумента и возвращает целый массив значений:

ЛИНЕЙН(известные_значения_y; [известные_значения_x]; [конст]; [статистика])

Если 4-й аргумент

статистика

имеет значение ЛОЖЬ или опущен, то функция

ЛИНЕЙН()

возвращает только оценки параметров модели:

a

и

b

.

Примечание

: Остальные значения, возвращаемые функцией

ЛИНЕЙН()

, нам потребуются при вычислении

стандартных ошибок

и для

проверки значимости регрессии

. В этом случае аргумент

статистика

должен иметь значение ИСТИНА.

Чтобы вывести сразу обе оценки:

- в одной строке необходимо выделить 2 ячейки,

-

ввести формулу в

Строке формул

-

нажать

CTRL

+

SHIFT

+

ENTER

(см. статью проформулы массива

).

Если в

Строке формул

выделить формулу =

ЛИНЕЙН(C23:C83;B23:B83)

и нажать

клавишу F9

, то мы увидим что-то типа {3,01279389265416;154,240057900613}. Это как раз значения

a

и

b

. Как видно, оба значения разделены точкой с запятой «;», что свидетельствует, что функция вернула значения «в нескольких ячейках одной строки».

Если требуется вывести параметры линии не в одной строке, а одном столбце (ячейки друг под другом), то используйте формулу =

ТРАНСП(ЛИНЕЙН(C23:C83;B23:B83))

. При этом выделять нужно 2 ячейки в одном столбце. Если теперь выделить новую формулу и нажать клавишу F9, то мы увидим что 2 значения разделены двоеточием «:», что означает, что значения выведены в столбец (функция

ТРАНСП()

транспонировала строку в столбец

).

Чтобы разобраться в этом подробнее необходимо ознакомиться с

формулами массива

.

Чтобы не связываться с вводом

формул массива

, можно

использовать функцию ИНДЕКС()

. Формула =

ИНДЕКС(ЛИНЕЙН(C23:C83;B23:B83);1)

или просто

ЛИНЕЙН(C23:C83;B23:B83)

вернет параметр, отвечающий за наклон линии, т.е.

а

. Формула

=ИНДЕКС(ЛИНЕЙН(C23:C83;B23:B83);2)

вернет параметр

b

.

Оценка неизвестных параметров линейной модели (через статистики выборок)

Наклон линии, т.е. коэффициент

а

, можно также вычислить через

коэффициент корреляции

и

стандартные отклонения выборок

:

=

КОРРЕЛ(B23:B83;C23:C83) *(СТАНДОТКЛОН.В(C23:C83)/ СТАНДОТКЛОН.В(B23:B83))

Вышеуказанная формула математически эквивалентна отношению

ковариации

выборок Х и Y и

дисперсии

выборки Х:

=

КОВАРИАЦИЯ.В(B23:B83;C23:C83)/ДИСП.В(B23:B83)

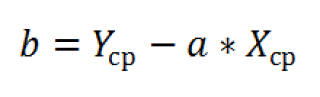

И, наконец, запишем еще одну формулу для нахождения сдвига

b

. Воспользуемся тем фактом, что

линия регрессии

проходит через точку

средних значений

переменных Х и Y.

Вычислив

средние значения

и подставив в формулу ранее найденный наклон

а

, получим сдвиг

b

.

Оценка неизвестных параметров линейной модели (матричная форма)

Также параметры

линии регрессии

можно найти в матричной форме (см.

файл примера лист Матричная форма

).

В формуле символом β обозначен столбец с искомыми параметрами модели: β0 (сдвиг

b

), β1 (наклон

a

).

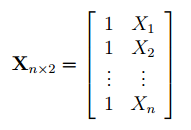

Матрица Х равна:

Матрица

Х

называется

регрессионной матрицей

или

матрицей плана

. Она состоит из 2-х столбцов и n строк, где n – количество точек данных. Первый столбец — столбец единиц, второй – значения переменной Х.

Матрица

Х

T

– это

транспонированная матрица

Х

. Она состоит соответственно из n столбцов и 2-х строк.

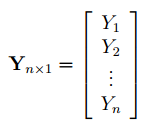

В формуле символом

Y

обозначен столбец значений переменной Y.

Матрица

Х

называется

регрессионной матрицей

или

матрицей плана

. Она состоит из 2-х столбцов и n строк, где n – количество точек данных. Первый столбец — столбец единиц, второй – значения переменной Х.

Матрица

Х

T

– это

транспонированная матрица

Х

. Она состоит соответственно из n столбцов и 2-х строк.

В формуле символом

Y

обозначен столбец значений переменной Y.

Чтобы

перемножить матрицы

используйте функцию

МУМНОЖ()

. Чтобы

найти обратную матрицу

используйте функцию

МОБР()

.

Пусть дан массив значений переменных Х и Y (n=10, т.е.10 точек).

Слева от него достроим столбец с 1 для матрицы Х.

Записав формулу

=

МУМНОЖ(МОБР(МУМНОЖ(ТРАНСП(B7:C16);(B7:C16))); МУМНОЖ(ТРАНСП(B7:C16);(D7:D16)))

и введя ее как

формулу массива

в 2 ячейки, получим оценку параметров модели.

Красота применения матричной формы полностью раскрывается в случае

множественной регрессии

.

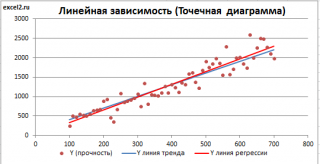

Построение линии регрессии

Для отображения

линии регрессии

построим сначала

диаграмму рассеяния

, на которой отобразим все точки (см.

начало статьи

).

Для построения прямой линии используйте вычисленные выше оценки параметров модели

a

и

b

(т.е. вычислите

у

по формуле

y

=

a

*

x

+

b

) или функцию

ТЕНДЕНЦИЯ()

.

Формула =

ТЕНДЕНЦИЯ($C$23:$C$83;$B$23:$B$83;B23)

возвращает расчетные (прогнозные) значения ŷi для заданного значения Хi из столбца

В2

.

Примечание

:

Линию регрессии

можно также построить с помощью функции

ПРЕДСКАЗ()

. Эта функция возвращает прогнозные значения ŷi, но, в отличие от функции

ТЕНДЕНЦИЯ()

работает только в случае одного регрессора. Функция

ТЕНДЕНЦИЯ()

может быть использована и в случае

множественной регрессии

(в этом случае 3-й аргумент функции должен быть ссылкой на диапазон, содержащий все значения Хi для выбранного наблюдения i).

Как видно из диаграммы выше

линия тренда

и

линия регрессии

не обязательно совпадают: отклонения точек от

линии тренда

случайны, а МНК лишь подбирает линию наиболее точно аппроксимирующую случайные точки данных.

Линию регрессии

можно построить и с помощью встроенных средств диаграммы, т.е. с помощью инструмента

Линия тренда.

Для этого выделите диаграмму, в меню выберите

вкладку Макет

, в

группе Анализ

нажмите

Линия тренда

, затем

Линейное приближение.

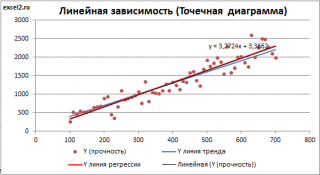

В диалоговом окне установите галочку

Показывать уравнение на диаграмме

(подробнее см. в

статье про МНК

).

Построенная таким образом линия, разумеется, должна совпасть с ранее построенной нами

линией регрессии,

а параметры уравнения

a

и

b

должны совпасть с параметрами уравнения отображенными на диаграмме.

Примечание:

Для того, чтобы вычисленные параметры уравнения

a

и

b

совпадали с параметрами уравнения на диаграмме, необходимо, чтобы тип у диаграммы был

Точечная, а не График

, т.к. тип диаграммы

График

не использует значения Х, а вместо значений Х используется последовательность 1; 2; 3; … Именно эти значения и берутся при расчете параметров

линии тренда

. Убедиться в этом можно если построить диаграмму

График

(см.

файл примера

), а значения

Хнач

и

Хшаг

установить равным 1. Только в этом случае параметры уравнения на диаграмме совпадут с

a

и

b

.

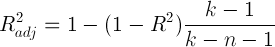

Коэффициент детерминации R

2

Коэффициент детерминации

R

2

показывает насколько полезна построенная нами

линейная регрессионная модель

.

Предположим, что у нас есть n значений переменной Y и мы хотим предсказать значение yi, но без использования значений переменной Х (т.е. без построения

регрессионной модели

). Очевидно, что лучшей оценкой для yi будет

среднее значение

ȳ. Соответственно, ошибка предсказания будет равна (yi — ȳ).

Примечание

: Далее будет использована терминология и обозначения

дисперсионного анализа

.

После построения

регрессионной модели

для предсказания значения yi мы будем использовать значение ŷi=a*xi+b. Ошибка предсказания теперь будет равна (yi — ŷi).

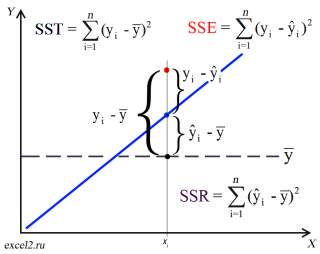

Теперь с помощью диаграммы сравним ошибки предсказания полученные без построения модели и с помощью модели.

Очевидно, что используя

регрессионную модель

мы уменьшили первоначальную (полную) ошибку (yi — ȳ) на значение (ŷi — ȳ) до величины (yi — ŷi).

(yi — ŷi) – это оставшаяся, необъясненная ошибка.

Очевидно, что все три ошибки связаны выражением:

(yi — ȳ)= (ŷi — ȳ) + (yi — ŷi)

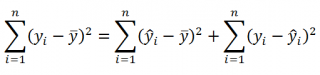

Можно показать, что в общем виде справедливо следующее выражение:

Доказательство:

или в других, общепринятых в зарубежной литературе, обозначениях:

SST

=

SSR

+

SSE

Что означает:

Total Sum of Squares

=

Regression Sum of Squares

+

Error Sum of Squares

Примечание

: SS — Sum of Squares — Сумма Квадратов.

Как видно из формулы величины SST, SSR, SSE имеют размерность

дисперсии

(вариации) и соответственно описывают разброс (изменчивость):

Общую изменчивость

(Total variation),

Изменчивость объясненную моделью

(Explained variation) и

Необъясненную изменчивость

(Unexplained variation).

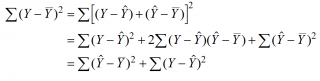

По определению

коэффициент детерминации

R

2

равен:

R

2

=

Изменчивость объясненная моделью / Общая изменчивость.

Этот показатель равен квадрату

коэффициента корреляции

и в MS EXCEL его можно вычислить с помощью функции

КВПИРСОН()

или

ЛИНЕЙН()

:

=

ИНДЕКС(ЛИНЕЙН(C23:C83;B23:B83;;ИСТИНА);3)

R

2

принимает значения от 0 до 1 (1 соответствует идеальной линейной зависимости Y от Х). Однако, на практике малые значения R2 вовсе не обязательно указывают, что переменную Х нельзя использовать для прогнозирования переменной Y. Малые значения R2 могут указывать на нелинейность связи или на то, что поведение переменной Y объясняется не только Х, но и другими факторами.

Стандартная ошибка регрессии

Стандартная ошибка регрессии

(

Standard Error of a regression

) показывает насколько велика ошибка предсказания значений переменной Y на основании значений Х. Отдельные значения Yi мы можем предсказывать лишь с точностью +/- несколько значений (обычно 2-3, в зависимости от формы распределения ошибки ε).

Теперь вспомним уравнение

линейной регрессионной модели

Y=a*X+β+ε. Ошибка ε имеет случайную природу, т.е. является случайной величиной и поэтому имеет свою функцию распределения со

средним значением

μ и

дисперсией

σ

2

.

Оценив значение

дисперсии

σ

2

и вычислив из нее квадратный корень – получим

Стандартную ошибку регрессии.

Чем точки наблюдений на диаграмме

рассеяния

ближе находятся к прямой линии, тем меньше

Стандартная ошибка.

Примечание

:

Вспомним

, что при построении модели предполагается, что

среднее значение

ошибки ε равно 0, т.е. E[ε]=0.

Оценим

дисперсию σ

2

. Помимо вычисления

Стандартной ошибки регрессии

эта оценка нам потребуется в дальнейшем еще и при построении

доверительных интервалов

для оценки параметров регрессии

a

и

b

.

Для оценки

дисперсии

ошибки ε используем

остатки регрессии

— разности между имеющимися значениями

yi

и значениями, предсказанными регрессионной моделью ŷ. Чем лучше регрессионная модель согласуется с данными (точки располагается близко к прямой линии), тем меньше величина остатков.

Для оценки

дисперсии σ

2

используют следующую формулу:

Слева от него достроим столбец с 1 для матрицы Х.

Записав формулу

=

МУМНОЖ(МОБР(МУМНОЖ(ТРАНСП(B7:C16);(B7:C16))); МУМНОЖ(ТРАНСП(B7:C16);(D7:D16)))

и введя ее как

формулу массива

в 2 ячейки, получим оценку параметров модели.

Красота применения матричной формы полностью раскрывается в случае

множественной регрессии

.

Построение линии регрессии

Для отображения

линии регрессии

построим сначала

диаграмму рассеяния

, на которой отобразим все точки (см.

начало статьи

).

Для построения прямой линии используйте вычисленные выше оценки параметров модели

a

и

b

(т.е. вычислите

у

по формуле

y

=

a

*

x

+

b

) или функцию

ТЕНДЕНЦИЯ()

.

Формула =

ТЕНДЕНЦИЯ($C$23:$C$83;$B$23:$B$83;B23)

возвращает расчетные (прогнозные) значения ŷi для заданного значения Хi из столбца

В2

.

Примечание

:

Линию регрессии

можно также построить с помощью функции

ПРЕДСКАЗ()

. Эта функция возвращает прогнозные значения ŷi, но, в отличие от функции

ТЕНДЕНЦИЯ()

работает только в случае одного регрессора. Функция

ТЕНДЕНЦИЯ()

может быть использована и в случае

множественной регрессии

(в этом случае 3-й аргумент функции должен быть ссылкой на диапазон, содержащий все значения Хi для выбранного наблюдения i).

Как видно из диаграммы выше

линия тренда

и

линия регрессии

не обязательно совпадают: отклонения точек от

линии тренда

случайны, а МНК лишь подбирает линию наиболее точно аппроксимирующую случайные точки данных.

Линию регрессии

можно построить и с помощью встроенных средств диаграммы, т.е. с помощью инструмента

Линия тренда.

Для этого выделите диаграмму, в меню выберите

вкладку Макет

, в

группе Анализ

нажмите

Линия тренда

, затем

Линейное приближение.

В диалоговом окне установите галочку

Показывать уравнение на диаграмме

(подробнее см. в

статье про МНК

).

Построенная таким образом линия, разумеется, должна совпасть с ранее построенной нами

линией регрессии,

а параметры уравнения

a

и

b

должны совпасть с параметрами уравнения отображенными на диаграмме.

Примечание:

Для того, чтобы вычисленные параметры уравнения

a

и

b

совпадали с параметрами уравнения на диаграмме, необходимо, чтобы тип у диаграммы был

Точечная, а не График

, т.к. тип диаграммы

График

не использует значения Х, а вместо значений Х используется последовательность 1; 2; 3; … Именно эти значения и берутся при расчете параметров

линии тренда

. Убедиться в этом можно если построить диаграмму

График

(см.

файл примера

), а значения

Хнач

и

Хшаг

установить равным 1. Только в этом случае параметры уравнения на диаграмме совпадут с

a

и

b

.

Коэффициент детерминации R

2

Коэффициент детерминации

R

2

показывает насколько полезна построенная нами

линейная регрессионная модель

.

Предположим, что у нас есть n значений переменной Y и мы хотим предсказать значение yi, но без использования значений переменной Х (т.е. без построения

регрессионной модели

). Очевидно, что лучшей оценкой для yi будет

среднее значение

ȳ. Соответственно, ошибка предсказания будет равна (yi — ȳ).

Примечание

: Далее будет использована терминология и обозначения

дисперсионного анализа

.

После построения

регрессионной модели

для предсказания значения yi мы будем использовать значение ŷi=a*xi+b. Ошибка предсказания теперь будет равна (yi — ŷi).

Теперь с помощью диаграммы сравним ошибки предсказания полученные без построения модели и с помощью модели.

Очевидно, что используя

регрессионную модель

мы уменьшили первоначальную (полную) ошибку (yi — ȳ) на значение (ŷi — ȳ) до величины (yi — ŷi).

(yi — ŷi) – это оставшаяся, необъясненная ошибка.

Очевидно, что все три ошибки связаны выражением:

(yi — ȳ)= (ŷi — ȳ) + (yi — ŷi)

Можно показать, что в общем виде справедливо следующее выражение:

Доказательство:

или в других, общепринятых в зарубежной литературе, обозначениях:

SST

=

SSR

+

SSE

Что означает:

Total Sum of Squares

=

Regression Sum of Squares

+

Error Sum of Squares

Примечание

: SS — Sum of Squares — Сумма Квадратов.

Как видно из формулы величины SST, SSR, SSE имеют размерность

дисперсии

(вариации) и соответственно описывают разброс (изменчивость):

Общую изменчивость

(Total variation),

Изменчивость объясненную моделью

(Explained variation) и

Необъясненную изменчивость

(Unexplained variation).

По определению

коэффициент детерминации

R

2

равен:

R

2

=

Изменчивость объясненная моделью / Общая изменчивость.

Этот показатель равен квадрату

коэффициента корреляции

и в MS EXCEL его можно вычислить с помощью функции

КВПИРСОН()

или

ЛИНЕЙН()

:

=

ИНДЕКС(ЛИНЕЙН(C23:C83;B23:B83;;ИСТИНА);3)

R

2

принимает значения от 0 до 1 (1 соответствует идеальной линейной зависимости Y от Х). Однако, на практике малые значения R2 вовсе не обязательно указывают, что переменную Х нельзя использовать для прогнозирования переменной Y. Малые значения R2 могут указывать на нелинейность связи или на то, что поведение переменной Y объясняется не только Х, но и другими факторами.

Стандартная ошибка регрессии

Стандартная ошибка регрессии

(

Standard Error of a regression

) показывает насколько велика ошибка предсказания значений переменной Y на основании значений Х. Отдельные значения Yi мы можем предсказывать лишь с точностью +/- несколько значений (обычно 2-3, в зависимости от формы распределения ошибки ε).

Теперь вспомним уравнение

линейной регрессионной модели

Y=a*X+β+ε. Ошибка ε имеет случайную природу, т.е. является случайной величиной и поэтому имеет свою функцию распределения со

средним значением

μ и

дисперсией

σ

2

.

Оценив значение

дисперсии

σ

2

и вычислив из нее квадратный корень – получим

Стандартную ошибку регрессии.

Чем точки наблюдений на диаграмме

рассеяния

ближе находятся к прямой линии, тем меньше

Стандартная ошибка.

Примечание

:

Вспомним

, что при построении модели предполагается, что

среднее значение

ошибки ε равно 0, т.е. E[ε]=0.

Оценим

дисперсию σ

2

. Помимо вычисления

Стандартной ошибки регрессии

эта оценка нам потребуется в дальнейшем еще и при построении

доверительных интервалов

для оценки параметров регрессии

a

и

b

.

Для оценки

дисперсии

ошибки ε используем

остатки регрессии

— разности между имеющимися значениями

yi

и значениями, предсказанными регрессионной моделью ŷ. Чем лучше регрессионная модель согласуется с данными (точки располагается близко к прямой линии), тем меньше величина остатков.

Для оценки

дисперсии σ

2

используют следующую формулу:

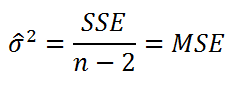

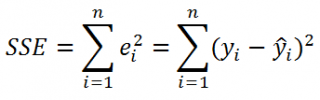

где SSE – сумма квадратов значений ошибок модели ε

i

=yi — ŷi (

Sum of Squared Errors

).

SSE часто обозначают и как SSres – сумма квадратов остатков (

Sum

of

Squared

residuals

).

Оценка

дисперсии

s

2

также имеет общепринятое обозначение MSE (Mean Square of Errors), т.е. среднее квадратов

ошибок

или MSRES (Mean Square of Residuals), т.е. среднее квадратов

остатков

. Хотя правильнее говорить сумме квадратов остатков, т.к. ошибка чаще ассоциируется с ошибкой модели ε, которая является непрерывной случайной величиной. Но, здесь мы будем использовать термины SSE и MSE, предполагая, что речь идет об остатках.

Примечание

: Напомним, что когда

мы использовали МНК

для нахождения параметров модели, то критерием оптимизации была минимизация именно SSE (SSres). Это выражение представляет собой сумму квадратов расстояний между наблюденными значениями yi и предсказанными моделью значениями ŷi, которые лежат на

линии регрессии.

Математическое ожидание

случайной величины MSE равно

дисперсии ошибки

ε, т.е.

σ

2

.

Чтобы понять почему SSE выбрана в качестве основы для оценки

дисперсии

ошибки ε, вспомним, что

σ

2

является также

дисперсией

случайной величины Y (относительно

среднего значения

μy, при заданном значении Хi). А т.к. оценкой μy является значение ŷi =

a

* Хi +

b

(значение

уравнения регрессии

при Х= Хi), то логично использовать именно SSE в качестве основы для оценки

дисперсии

σ

2

. Затем SSE усредняется на количество точек данных n за вычетом числа 2. Величина n-2 – это количество

степеней свободы

(

df

–

degrees

of

freedom

), т.е. число параметров системы, которые могут изменяться независимо (вспомним, что у нас в этом примере есть n независимых наблюдений переменной Y). В случае

простой линейной регрессии

число степеней свободы

равно n-2, т.к. при построении

линии регрессии

было оценено 2 параметра модели (на это было «потрачено» 2

степени свободы

).

Итак, как сказано было выше, квадратный корень из s

2

имеет специальное название

Стандартная ошибка регрессии

(

Standard Error of a regression

) и обозначается SEy. SEy показывает насколько велика ошибка предсказания. Отдельные значения Y мы можем предсказывать с точностью +/- несколько значений SEy (см.

этот раздел

). Если ошибки предсказания ε имеют

нормальное распределение

, то примерно 2/3 всех предсказанных значений будут на расстоянии не больше SEy от

линии регрессии

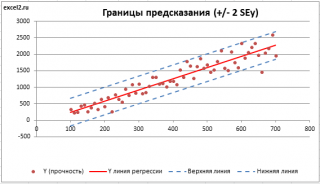

. SEy имеет размерность переменной Y и откладывается по вертикали. Часто на

диаграмме рассеяния

строят

границы предсказания

соответствующие +/- 2 SEy (т.е. 95% точек данных будут располагаться в пределах этих границ).

В MS EXCEL

стандартную ошибку

SEy можно вычислить непосредственно по формуле:

=

КОРЕНЬ(СУММКВРАЗН(C23:C83; ТЕНДЕНЦИЯ(C23:C83;B23:B83;B23:B83)) /( СЧЁТ(B23:B83) -2))

или с помощью функции

ЛИНЕЙН()

:

=

ИНДЕКС(ЛИНЕЙН(C23:C83;B23:B83;;ИСТИНА);3;2)

Примечание

: Подробнее о функции

ЛИНЕЙН()

см.

эту статью

.

Стандартные ошибки и доверительные интервалы для наклона и сдвига

В разделе

Оценка неизвестных параметров линейной модели

мы получили точечные оценки наклона

а

и сдвига

b

. Так как эти оценки получены на основе случайных величин (значений переменных Х и Y), то эти оценки сами являются случайными величинами и соответственно имеют функцию распределения со

средним значением

и

дисперсией

. Но, чтобы перейти от

точечных оценок

к

интервальным

, необходимо вычислить соответствующие

стандартные ошибки

(т.е.

стандартные отклонения

).

Стандартная ошибка коэффициента регрессии

a

вычисляется на основании

стандартной ошибки регрессии

по следующей формуле:

SSE часто обозначают и как SSres – сумма квадратов остатков (

Sum

of

Squared

residuals

).

Оценка

дисперсии

s

2

также имеет общепринятое обозначение MSE (Mean Square of Errors), т.е. среднее квадратов

ошибок

или MSRES (Mean Square of Residuals), т.е. среднее квадратов

остатков

. Хотя правильнее говорить сумме квадратов остатков, т.к. ошибка чаще ассоциируется с ошибкой модели ε, которая является непрерывной случайной величиной. Но, здесь мы будем использовать термины SSE и MSE, предполагая, что речь идет об остатках.

Примечание

: Напомним, что когда

мы использовали МНК

для нахождения параметров модели, то критерием оптимизации была минимизация именно SSE (SSres). Это выражение представляет собой сумму квадратов расстояний между наблюденными значениями yi и предсказанными моделью значениями ŷi, которые лежат на

линии регрессии.

Математическое ожидание

случайной величины MSE равно

дисперсии ошибки

ε, т.е.

σ

2

.

Чтобы понять почему SSE выбрана в качестве основы для оценки

дисперсии

ошибки ε, вспомним, что

σ

2

является также

дисперсией

случайной величины Y (относительно

среднего значения

μy, при заданном значении Хi). А т.к. оценкой μy является значение ŷi =

a

* Хi +

b

(значение

уравнения регрессии

при Х= Хi), то логично использовать именно SSE в качестве основы для оценки

дисперсии

σ

2

. Затем SSE усредняется на количество точек данных n за вычетом числа 2. Величина n-2 – это количество

степеней свободы

(

df

–

degrees

of

freedom

), т.е. число параметров системы, которые могут изменяться независимо (вспомним, что у нас в этом примере есть n независимых наблюдений переменной Y). В случае

простой линейной регрессии

число степеней свободы

равно n-2, т.к. при построении

линии регрессии

было оценено 2 параметра модели (на это было «потрачено» 2

степени свободы

).

Итак, как сказано было выше, квадратный корень из s

2

имеет специальное название

Стандартная ошибка регрессии

(

Standard Error of a regression

) и обозначается SEy. SEy показывает насколько велика ошибка предсказания. Отдельные значения Y мы можем предсказывать с точностью +/- несколько значений SEy (см.

этот раздел

). Если ошибки предсказания ε имеют

нормальное распределение

, то примерно 2/3 всех предсказанных значений будут на расстоянии не больше SEy от

линии регрессии

. SEy имеет размерность переменной Y и откладывается по вертикали. Часто на

диаграмме рассеяния

строят

границы предсказания

соответствующие +/- 2 SEy (т.е. 95% точек данных будут располагаться в пределах этих границ).

В MS EXCEL

стандартную ошибку

SEy можно вычислить непосредственно по формуле:

=

КОРЕНЬ(СУММКВРАЗН(C23:C83; ТЕНДЕНЦИЯ(C23:C83;B23:B83;B23:B83)) /( СЧЁТ(B23:B83) -2))

или с помощью функции

ЛИНЕЙН()

:

=

ИНДЕКС(ЛИНЕЙН(C23:C83;B23:B83;;ИСТИНА);3;2)

Примечание

: Подробнее о функции

ЛИНЕЙН()

см.

эту статью

.

Стандартные ошибки и доверительные интервалы для наклона и сдвига

В разделе

Оценка неизвестных параметров линейной модели

мы получили точечные оценки наклона

а

и сдвига

b

. Так как эти оценки получены на основе случайных величин (значений переменных Х и Y), то эти оценки сами являются случайными величинами и соответственно имеют функцию распределения со

средним значением

и

дисперсией

. Но, чтобы перейти от

точечных оценок

к

интервальным

, необходимо вычислить соответствующие

стандартные ошибки

(т.е.

стандартные отклонения

).

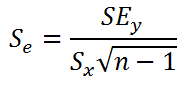

Стандартная ошибка коэффициента регрессии

a

вычисляется на основании

стандартной ошибки регрессии

по следующей формуле:

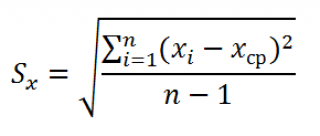

где Sx – стандартное отклонение величины х, вычисляемое по формуле:

где Sey –

стандартная ошибка регрессии,

т.е. ошибка предсказания значения переменой Y

(

см. выше

).

В MS EXCEL

стандартную ошибку коэффициента регрессии

Se можно вычислить впрямую по вышеуказанной формуле:

=

КОРЕНЬ(СУММКВРАЗН(C23:C83; ТЕНДЕНЦИЯ(C23:C83;B23:B83;B23:B83)) /( СЧЁТ(B23:B83) -2))/ СТАНДОТКЛОН.В(B23:B83) /КОРЕНЬ(СЧЁТ(B23:B83) -1)

или с помощью функции

ЛИНЕЙН()

:

=

ИНДЕКС(ЛИНЕЙН(C23:C83;B23:B83;;ИСТИНА);2;1)

Формулы приведены в

файле примера на листе Линейный

в разделе

Регрессионная статистика

.

Примечание

: Подробнее о функции

ЛИНЕЙН()

см.

эту статью

.

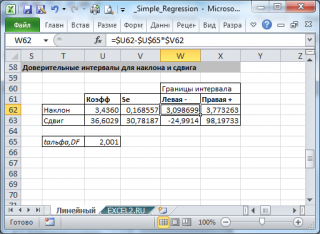

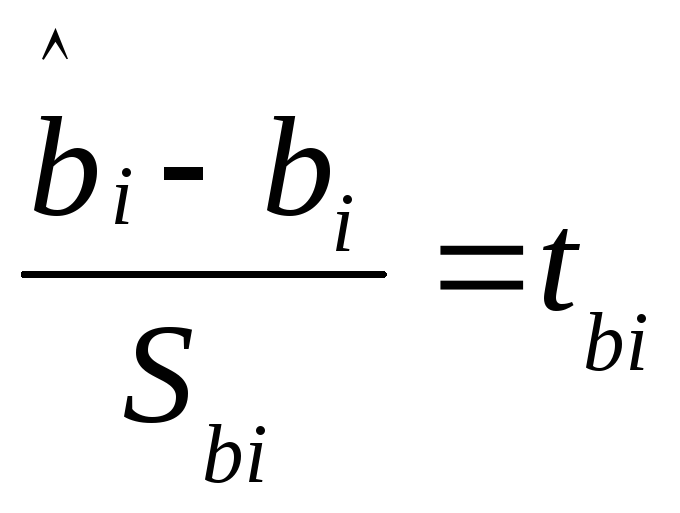

При построении

двухстороннего доверительного интервала

для

коэффициента регрессии

его границы определяются следующим образом:

где —

квантиль распределения Стьюдента

с n-2 степенями свободы. Величина

а

с «крышкой» является другим обозначением

наклона

а

.

Например для

уровня значимости

альфа=0,05, можно вычислить с помощью формулы

=СТЬЮДЕНТ.ОБР.2Х(0,05;n-2)

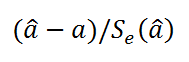

Вышеуказанная формула следует из того факта, что если ошибки регрессии распределены нормально и независимо, то выборочное распределение случайной величины

где Sey –

стандартная ошибка регрессии,

т.е. ошибка предсказания значения переменой Y

(

см. выше

).

В MS EXCEL

стандартную ошибку коэффициента регрессии

Se можно вычислить впрямую по вышеуказанной формуле:

=

КОРЕНЬ(СУММКВРАЗН(C23:C83; ТЕНДЕНЦИЯ(C23:C83;B23:B83;B23:B83)) /( СЧЁТ(B23:B83) -2))/ СТАНДОТКЛОН.В(B23:B83) /КОРЕНЬ(СЧЁТ(B23:B83) -1)

или с помощью функции

ЛИНЕЙН()

:

=

ИНДЕКС(ЛИНЕЙН(C23:C83;B23:B83;;ИСТИНА);2;1)

Формулы приведены в

файле примера на листе Линейный

в разделе

Регрессионная статистика

.

Примечание

: Подробнее о функции

ЛИНЕЙН()

см.

эту статью

.

При построении

двухстороннего доверительного интервала

для

коэффициента регрессии

его границы определяются следующим образом:

где —

квантиль распределения Стьюдента

с n-2 степенями свободы. Величина

а

с «крышкой» является другим обозначением

наклона

а

.

Например для

уровня значимости

альфа=0,05, можно вычислить с помощью формулы

=СТЬЮДЕНТ.ОБР.2Х(0,05;n-2)

Вышеуказанная формула следует из того факта, что если ошибки регрессии распределены нормально и независимо, то выборочное распределение случайной величины

является

t-распределением Стьюдента

с n-2 степенью свободы (то же справедливо и для наклона

b

).

Примечание

: Подробнее о построении

доверительных интервалов

в MS EXCEL можно прочитать в этой статье

Доверительные интервалы в MS EXCEL

.

В результате получим, что найденный

доверительный интервал

с вероятностью 95% (1-0,05) накроет истинное значение

коэффициента регрессии.

Здесь мы считаем, что

коэффициент регрессии

a

имеет

распределение Стьюдента

с n-2

степенями свободы

(n – количество наблюдений, т.е. пар Х и Y).

Примечание

: Подробнее о построении

доверительных интервалов

с использованием t-распределения см. статью про построение

доверительных интервалов

для среднего

.

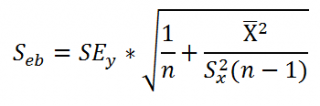

Стандартная ошибка сдвига

b

вычисляется по следующей формуле:

В MS EXCEL

стандартную ошибку сдвига

Seb можно вычислить с помощью функции

ЛИНЕЙН()

:

=

ИНДЕКС(ЛИНЕЙН(C23:C83;B23:B83;;ИСТИНА);2;2)

При построении

двухстороннего доверительного интервала

для

сдвига

его границы определяются аналогичным образом как для

наклона

:

b

+/- t*Seb.

Проверка значимости взаимосвязи переменных

Когда мы строим модель Y=αX+β+ε мы предполагаем, что между Y и X существует линейная взаимосвязь. Однако, как это иногда бывает в статистике, можно вычислять параметры связи даже тогда, когда в действительности она не существует, и обусловлена лишь случайностью.

Единственный вариант, когда Y не зависит X (в рамках модели Y=αX+β+ε), возможен, когда

коэффициент регрессии

a

равен 0.

Чтобы убедиться, что вычисленная нами оценка

наклона

прямой линии не обусловлена лишь случайностью (не случайно отлична от 0), используют

проверку гипотез

. В качестве

нулевой гипотезы

Н

0

принимают, что связи нет, т.е. a=0. В качестве альтернативной гипотезы

Н

1

принимают, что a <>0.

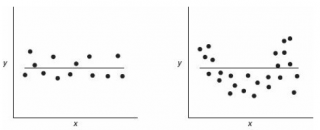

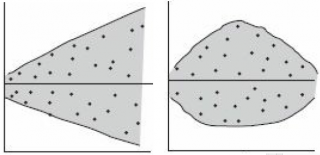

Ниже на рисунках показаны 2 ситуации, когда

нулевую гипотезу

Н

0

не удается отвергнуть.

На левой картинке отсутствует любая зависимость между переменными, на правой – связь между ними нелинейная, но при этом

коэффициент линейной корреляции

равен 0.

Ниже — 2 ситуации, когда

нулевая гипотеза

Н

0

отвергается.

На левой картинке очевидна линейная зависимость, на правой — зависимость нелинейная, но коэффициент корреляции не равен 0 (метод МНК вычисляет показатели наклона и сдвига просто на основании значений выборки).

Для проверки гипотезы нам потребуется:

-

Установить

уровень значимости

, пусть альфа=0,05;

-

Рассчитать с помощью функции

ЛИНЕЙН()

стандартное отклонение

Se для

коэффициента регрессии

(см.предыдущий раздел

);

-

Рассчитать число степеней свободы: DF=n-2 или по формуле =

ИНДЕКС(ЛИНЕЙН(C24:C84;B24:B84;;ИСТИНА);4;2)

-

Вычислить значение тестовой статистики t

0

=a/S

e

, которая имеетраспределение Стьюдента

с

числом степеней свободы

DF=n-2; -

Сравнить значение

тестовой статистики

|t0| с пороговым значением t

альфа

,n-2. Если значение

тестовой статистики

больше порогового значения, то

нулевая гипотеза

отвергается (

наклон

не может быть объяснен лишь случайностью при заданном уровне альфа) либо -

вычислить

p-значение

и сравнить его с

уровнем значимости

.

В

файле примера

приведен пример проверки гипотезы:

Изменяя

наклон

тренда k (ячейка

В8

) можно убедиться, что при малых углах тренда (например, 0,05) тест часто показывает, что связь между переменными случайна. При больших углах (k>1), тест практически всегда подтверждает значимость линейной связи между переменными.

Примечание

: Проверка значимости взаимосвязи эквивалентна

проверке статистической значимости коэффициента корреляции

. В

файле примера

показана эквивалентность обоих подходов. Также проверку значимости можно провести с помощью

процедуры F-тест

.

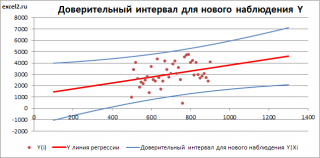

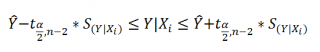

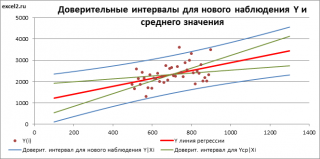

Доверительные интервалы для нового наблюдения Y и среднего значения

Вычислив параметры

простой линейной регрессионной модели

Y=aX+β+ε мы получили точечную оценку значения нового наблюдения Y при заданном значении Хi, а именно: Ŷ=

a

* Хi +

b

Ŷ также является точечной оценкой для

среднего значения

Yi при заданном Хi. Но, при построении

доверительных интервалов

используются различные

стандартные ошибки

.

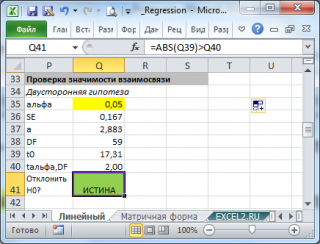

Стандартная ошибка

нового наблюдения Y при заданном Хi учитывает 2 источника неопределенности:

-

неопределенность связанную со случайностью оценок параметров модели

a

и

b

; - случайность ошибки модели ε.

Учет этих неопределенностей приводит к

стандартной ошибке

S(Y|Xi), которая рассчитывается с учетом известного значения Xi.

где SS

xx

– сумма квадратов отклонений от

среднего

значений переменной Х:

Примечание

: Se –

стандартная ошибка коэффициента регрессии

(

наклона

а

).

В

MS EXCEL 2010

нет функции, которая бы рассчитывала эту

стандартную ошибку

, поэтому ее необходимо рассчитывать по вышеуказанным формулам.

Доверительный интервал

или

Интервал предсказания для нового наблюдения

(Prediction Interval for a New Observation) построим по схеме показанной в разделе

Проверка значимости взаимосвязи переменных

(см.

файл примера лист Интервалы

). Т.к. границы интервала зависят от значения Хi (точнее от расстояния Хi до среднего значения Х

ср

), то интервал будет постепенно расширяться при удалении от Х

ср

.

Границы

доверительного интервала

для

нового наблюдения

рассчитываются по формуле:

Аналогичным образом построим

доверительный интервал

для

среднего значения

Y при заданном Хi (Confidence Interval for the Mean of Y). В этом случае

доверительный интервал

будет уже, т.к.

средние значения

имеют меньшую изменчивость по сравнению с отдельными наблюдениями (

средние значения,

в рамках нашей линейной модели Y=aX+β+ε, не включают ошибку ε).

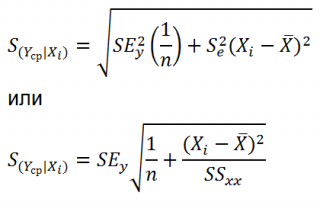

Стандартная ошибка

S(Yср|Xi) вычисляется по практически аналогичным формулам как и

стандартная ошибка

для нового наблюдения:

Как видно из формул,

стандартная ошибка

S(Yср|Xi) меньше

стандартной ошибки

S(Y|Xi) для индивидуального значения

.

Границы

доверительного интервала

для

среднего значения

рассчитываются по формуле:

Проверка адекватности линейной регрессионной модели

Модель адекватна, когда все предположения, лежащие в ее основе, выполнены (см. раздел

Предположения линейной регрессионной модели

).

Проверка адекватности модели в основном основана на исследовании остатков модели (model residuals), т.е. значений ei=yi – ŷi для каждого Хi. В рамках

простой линейной модели

n остатков имеют только n-2 связанных с ними

степеней свободы

. Следовательно, хотя, остатки не являются независимыми величинами, но при достаточно большом n это не оказывает какого-либо влияния на проверку адекватности модели.

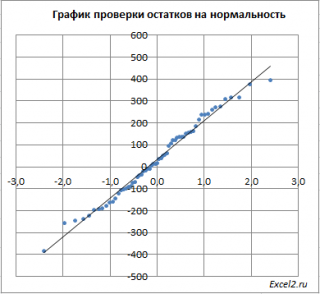

Чтобы проверить предположение о

нормальности распределения

ошибок строят

график проверки на нормальность

(Normal probability Plot).

В

файле примера на листе Адекватность

построен

график проверки на нормальность

. В случае

нормального распределения

значения остатков должны быть близки к прямой линии.

Так как значения переменной Y мы

генерировали с помощью тренда

, вокруг которого значения имели нормальный разброс, то ожидать сюрпризов не приходится – значения остатков располагаются вблизи прямой.

Также при проверке модели на адекватность часто строят график зависимости остатков от предсказанных значений Y. Если точки не демонстрируют характерных, так называемых «паттернов» (шаблонов) типа вор

о

нок или другого неравномерного распределения, в зависимости от значений Y, то у нас нет очевидных доказательств неадекватности модели.

В нашем случае точки располагаются примерно равномерно.

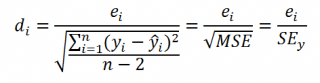

Часто при проверке адекватности модели вместо остатков используют нормированные остатки. Как показано в разделе

Стандартная ошибка регрессии

оценкой

стандартного отклонения ошибок

является величина SEy равная квадратному корню из величины MSE. Поэтому логично нормирование остатков проводить именно на эту величину.

SEy можно вычислить с помощью функции

ЛИНЕЙН()

:

=

ИНДЕКС(ЛИНЕЙН(C23:C83;B23:B83;;ИСТИНА);3;2)

Иногда нормирование остатков производится на величину

стандартного отклонения

остатков (это мы увидим в статье об инструменте

Регрессия

, доступного в

надстройке MS EXCEL Пакет анализа

), т.е. по формуле:

Вышеуказанное равенство приблизительное, т.к. среднее значение остатков близко, но не обязательно точно равно 0.

Оценка результатов линейной регрессии

Время на прочтение

6 мин

Количество просмотров 95K

Введение

Сегодня уже все, кто хоть немного интересуется дата майнингом, наверняка слышали про простую линейную регрессию. Про нее уже писали на хабре, а также подробно рассказывал Эндрю Нг в своем известном курсе машинного обучения. Линейная регрессия является одним из базовых и самых простых методов машинного обучения, однако очень редко упоминаются методы оценки качества построенной модели. В этой статье я постараюсь немного исправить это досадное упущение на примере разбора результатов функции summary.lm() в языке R. При этом я постараюсь предоставить необходимые формулы, таким образом все вычисления можно легко запрограммировать на любом другом языке. Эта статья предназначена для тех, кто слышал о том, что можно строить линейную регрессию, но не сталкивался со статистическими процедурами для оценки ее качества.

Модель линейной регрессии

Итак, пусть есть несколько независимых случайных величин X1, X2, …, Xn (предикторов) и зависящая от них величина Y (предполагается, что все необходимые преобразования предикторов уже сделаны). Более того, мы предполагаем, что зависимость линейная, а ошибки рапределены нормально, то есть

где I — единичная квадратная матрица размера n x n.

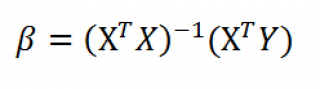

Итак, у нас есть данные, состоящие из k наблюдений величин Y и Xi и мы хотим оценить коэффициенты. Стандартным методом для нахождения оценок коэффициентов является метод наименьших квадратов. И аналитическое решение, которое можно получить, применив этот метод, выглядит так:

где b с крышкой — оценка вектора коэффициентов, y — вектор значений зависимой величины, а X — матрица размера k x n+1 (n — количество предикторов, k — количество наблюдений), у которой первый столбец состоит из единиц, второй — значения первого предиктора, третий — второго и так далее, а строки соответствуют имеющимся наблюдениям.

Функция summary.lm() и оценка получившихся результатов

Теперь рассмотрим пример построения модели линейной регрессии в языке R:

> library(faraway)

> lm1<-lm(Species~Area+Elevation+Nearest+Scruz+Adjacent, data=gala)

> summary(lm1)

Call:

lm(formula = Species ~ Area + Elevation + Nearest + Scruz + Adjacent,