Главная / Безопасность /

Основы теории информации и криптографии / Тест 8

Основы теории информации и криптографии — тест 8

Упражнение 1:

Номер 1

Коды делятся на классы:

Ответ:

(1) коды с обнаружением ошибок

(2) коды с корректированием ошибок

(3) коды с исправлением ошибок

(4) коды с управлением ошибками

(5) коды с изъятием ошибок

Номер 2

Коды с исправлением ошибок предназначены для:

Ответ:

(1) выявления вероятности, близкой к единице, наличие ошибок

(2) восстановления с вероятностью, близкой к единице, посланного сообщения

(3) управления ошибками в ходе отправки и получения сообщения

Номер 3

Коды с обнаружением ошибок предназначены для:

Ответ:

(1) выявления вероятности, близкой к единице, наличие ошибок

(2) восстановления с вероятностью, близкой к единице, посланного сообщения

(3) управления ошибками в ходе отправки и получения сообщения

Упражнение 2:

Номер 1

Простой код с обнаружением ошибок основан на:

Ответ:

(1) взаимодействии с другим кодом

(2) булевом методе проверки

(3) схеме проверки четности

Номер 2

Блочный код заменяет:

Ответ:

(1) четный блок из m символов более длинным блоком из n символов

(2) каждый блок из m символов более длинным блоком из n символов

(3) каждый блок из m символов более коротким блоком из n символов

Номер 3

Древовидные коды также называют:

Ответ:

(1) последовательными кодами

(2) параллельными кодами

(3) управляющими кодами

Упражнение 3:

Номер 1

Последовательные коды характеризуются тем, что:

Ответ:

(1) значение каждого символа зависит от части предшествующего фрагмента сообщения

(2) значение очередного контрольного символа НЕ зависит от всего предшествующего фрагмента сообщения

(3) значение очередного контрольного символа зависит от всего предшествующего фрагмента сообщения

Номер 2

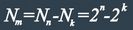

Расстоянием (Хэмминга) между двоичными словами длины n называется:

Ответ:

(1) количество четных позиций, в которых эти слова не встречаются

(2) количество позиций, в которых эти слова различаются

(3) количество позиций, в которых эти слова совпадают

Номер 3

Весом двоичного слова a=a1 ... a_n называется:

Ответ:

(1) количество единиц в нем

(2) количество нулей в нем

(3) общее количество цифр в нем

Упражнение 4:

Номер 1

Следующее утверждение верно:

Ответ:

(1) d(a,b) = w(a-b)

(2)

(3) d(a,b) = w(a+b)

Номер 2

Неравенством Варшамова - Гильберта называют выражение:

Ответ:

(1)

(2)

(3)

Номер 3

Имеется (8,9)-код с проверкой четности. Вычислить вероятность того, что в случае ошибки этот код ее не обнаружит, если вероятность ошибки при передаче каждого бита равна 1%:

Ответ:

(1)

(2)

(3)

Упражнение 5:

Номер 1

Имеется (8,9)-код с проверкой четности. Вычислить вероятность ошибочной передачи без использования кода, если вероятность ошибки при передаче каждого бита равна 1%:

Ответ:

(1)

(2)

(3)

Номер 2

Имеется (8,9)-код с проверкой четности. Вычислить вероятность того, что в случае ошибки этот код ее не обнаружит, если вероятность ошибки при передаче каждого бита равна 0.1%:

Ответ:

(1)

(2)

(3)

Номер 3

Имеется (8,9)-код с проверкой четности. Вычислить вероятность ошибочной передачи без использования кода, если вероятность ошибки при передаче каждого бита равна 0.1%:

Ответ:

(1)

(2)

(3)

Упражнение 6:

Номер 1

Преимущество матричного кодирования заключается в:

Ответ:

(1) определении объема полученных данных еще до начала кодирования

(2) использовании большего объема памяти по сравнению с другими методами кодирования

(3) использовании гораздо меньшего объема памяти по сравнению с другими методами кодирования

Номер 2

Вычислить минимальную и максимальную оценки количества дополнительных разрядов r для кодовых слов длины n, если требуется, чтобы минимальное расстояние между ними было d. Рассмотреть случаи n = 32, d = 3 и n = 23, d = 7:

Ответ:

(1)

(2)

(3)

Номер 3

Вычислить минимальную оценку по Плоткину количества дополнительных разрядов r для кодовых слов матричного кода, если требуется, чтобы минимальное расстояние между ними было d. Рассмотреть случаи n = 32, d = 3 и n = 23, d = 7:

Ответ:

(1)

(2)

(3)

Теория

кодирования занимается проблемами

построения разнообразных кодов. При

этом для конкретного класса кодов

решаются три основные задачи: 1) код

должен корректировать заданный класс

ошибок; 2) процедуры кодирования и

декодирования должны быть формализованы,

т. е. выполняться по определенным

правилам; 3) схемы кодирования и

декодирования должны быть простыми.

Рассмотрим

наиболее распространенные коды с

обнаружением ошибок. Каждый такой код

должен обнаруживать все одиночные

ошибки как наиболее вероятные. Кроме

того, он может и исправлять некоторые

ошибки.

Код

с контролем на четность.(1а) У

этого кода все разрешенные кодовые

слова содержат четное число единиц. Для

его формирования к обыкновенному

коду достаточно добавить один избыточный

контрольный разряд.

Пусть

надо передать S

= 4 сообщения. Тогда обыкновенный код

имеет два разряда, которые несут

информацию, а третий контрольный разряд

определяется исходя из четности числа

единиц в слове:

123

000 011 101

110 (столбик)

Такой

код, у которого разряды делятся на

информационные, служащие для передачи

сообщения, и контрольные (избыточные),

служащие для коррекции ошибок, называется

разделимым.

Равновесный

код (код с постоянным числом единиц). У

этого кода

все кодовые слова имеют постоянное

число единиц. Поэтому его еще называют

кодом «т

из

п»,

так

как каждое слово имеет т

единиц

из п

разрядов.

Число т

называют

весом

кода.

S=Cm,n

Корреляционные

коды. У этих кодов существует зависимость

(корреляция) между определенными

элементами кода. Примером является код

с повторением, у которого каждое слово

обыкновенного кода повторяется

дважды. Ниже приведен данный код для

передачи S

= 4 сообщений:

-

1

2

3

4

0

0

0

0

0

1

0

1

1

0

1

0

1

1 1 1

Он

является разделимым. Первый и второй

разряды можно считать информационными,

а третий и четвертый — контрольными.

34

Код

с суммированием (код Бергера). Этот

код позволяет обна руживать однонаправленные

ошибки любой кратности. Однонаправленным

назыв-ся кратные

Ошибки,

содержащие только искажения вида 1-0 или

0-1.код применяется в тех случаях,

Когда

в канале свзи возникают помехи,

длительность которых больше длительности

одного импульса тока.

35

11.5. Код Хемминга

Среди

кодов с исправлением ошибок наибольшее

распространение на практике имеет

код Хэмминга. Код

Хэмминга исправляет

ошибки кратности 1 и является разделимым.

Число информационных разрядов т

=

]log2N[,

где N

—

число сообщений, которые необходимо

передать. Длина кода определяется из

неравенства (11.14).

41

12.4.

Программируемые

распределители

Распределители,

работающие с использованием двоичного

кода,

имеют

2п

позиций.

Это число в системе ТУ — ТС обычно должно

быть равно длине используемого кода.

Поэтому возникает задача построения

распределителя (а фактически счетчика)

с модулем счета не равным 2″ Такие

распределители называют программируемыми.

42

Генераторы

в системах ТУ — ТС используются для

выполнения

двух

функций. Тактовые генераторы определяют

временное такты функционирования

системы. Они управляют работой счетчика

или распределителя и обеспечивают

синхронизацию. Генераторы качеств

формируют импульсы тока с определенным

качеством и воздействуют на линейные

устройства.

Генератором

называется

устройство, которое благодаря энергии

непериодического источника питания

создает периодически изменяющееся

электрическое напряжение или ток и

обеспечивает периодическое замыкание

и размыкание электрической цепи (1а).

В

зависимости от формы генерируемых

импульсов различают генераторы

синусоидальных колебаний (1 б) и

релаксационные генераторы. Последние

генерируют импульсы специальной

формы с наличием скачков — прямоугольные,

экспоненциальные, пилообразные (1 в,

г, д) и

др. При этом импульсные последовательности

характеризуются длительностями импульса

tи

и

паузы tn,

периодом

колебаний T

= tи

+tn,

частотой

следования f

= 1/Т

и

скважностью Q

=

T/tп.

Простейший

тактовый генератор (2 а)состоит из

источника питания ИП,

устройства

управления УУ,

накопителя

энергии Я и обратной связи ОС. В качестве

У

У используется

переключательный элемент (реле,

транзистор, тиристор и т. п.). Накопителем

энергии обычно служит конденсатор.

Пример

релейно-контактного генератора

(пульс-пара) рассмотрен в п. 5.3.

В

бесконтактной технике аналогами

пульс-пары являются мультивибраторы.

Простейшая схема мультивибратора

состоит из двух инверторов с емкостными

обратными связями (3а).

При

включении питания эта схема оказывается

в состоянии неустойчивого равновесия,

когда оба транзистора открыты с некоторой

степенью насыщения. Возрастание

коллекторного тока iК2

транзистора VT2

приводит

к увеличению тока заряда tc1

и увеличению падения напряжения на

резисторе Rb1.

В результате потенциал базы транзистора

VT1

становится более положительным и

уменьшается ток iK1.

Потенциал коллектора транзистора VT1

становится

более отрицательным и поэтому увеличивается

ток заряда ic2.

Так как последний является базовым

током транзистора VT2,

то

возрастает ток iK2

и

снова возрастает ток гс!

и т. д. Описанный процесс приводит к

тому, что транзистор VT2

полностью

открывается, а транзистор VT1

полностью

закрывается. Это состояние схемы также

неустойчиво, так как продолжается заряд

конденсатора С1 и ток icl

начинает уменьшаться. Снижается падение

напряжения на резисторе Rb1,

потенциал

базы транзистора VT1

становится

более отрицательным. При некотором

значении этого потенциала транзистор

VT1

начинает

открываться, возрастает его ток iK1

и

процесс протекает в обратную сторону.

На выходе схемы формируются импульсы

(3б), частота следования которых

определяется постоянной времени R6C.

44

Мир сейчас полностью зависит от хранения и передачи цифровых данных. Самолеты, фондовые рынки, системы безопасности, скороварки – современная жизнь быстро обрушится в хаос, если мы не сможем обеспечить точность в постоянно текущем и необъятно огромном потоке из единиц и нулей.

Есть две основные задачи, связанные с поддержанием целостности наших цифровых данных. Первое – это избегать в первую очередь ошибок; эта цель включает в себя множество инженерных практик, которые способствуют надежной передаче и приему цифровых данных. Но, несмотря на все наши усилия, ошибки возможны, и это приводит нас ко второй задаче: обнаружение ошибок. Если система может обнаруживать ошибки, она также может компенсировать эти ошибки, просто отбросив сомнительные данные или запросив повторную передачу.

Выбор метода обнаружения ошибок

Если вы знакомы с битом четности, который иногда используется в связи через UART, вы что-то знаете об обнаружении ошибок. Но бит четности является довольно жалким механизмом обнаружения ошибок; на самом деле, насколько я могу судить, большинство методов обнаружения ошибок более или менее жалки по сравнению с циклическим избыточным кодом (CRC, cyclic redundancy check), который явно стал доминирующим подходом – некоторые крупные имена в цифровой связи (включая CAN, USB и Ethernet) используют CRC как часть своего протокола передачи данных.

Эффективный, но не простой

Эта короткая статья не является местом для изучения подробностей вычислений и производительности CRC. Суть в том, что двоичный «многочлен» применяется к потоку данных таким образом, чтобы генерировать контрольную сумму, которая, скорее всего, изменится, если один или несколько битов сообщении были изменены.

Этот «многочлен» представляет собой просто математически удобный способ обращения к определенной последовательности битов. Например:

Это широко используемый полином «CCITT». Это полином 16-го порядка, что означает, что соответствующее двоичное число имеет ширину 16 бит, и что итоговая контрольная сумма CRC будет иметь ширину 16 бит. (Обратите внимание, что коэффициент для члена высшего порядка считается равным 1 и опускается в двоичной версии.) Члены, которые не отображаются в математическом выражении, имеют в качестве коэффициента двоичный 0.

Два CRC, не один

Создание CRC только для исходного сообщения вам не поможет. Ключом к реализации обнаружения ошибок CRC является обеспечение того, чтобы и передатчик, и приемник генерировали контрольную сумму одним и тем же способом.

Передатчик генерирует контрольную сумму для передаваемых данных и включает ее в исходное сообщение, а приемник генерирует собственную контрольную сумму с использованием полученных данных. Если сообщение приемника не совпадает с сообщением передатчика, весьма вероятно, что контрольные суммы будут отличаться; таким образом, приемник считает данные ошибочными, если контрольные суммы CRC не совпадают.

Куда двигаться дальше

Вы должны знать, что обработка CRC может использоваться фактически для исправления ошибок, а не просто для их обнаружения. Здесь мы имеем дело с двоичными данными, поэтому, если CRC позволяет нам идентифицировать ошибочный бит, мы можем восстановить исходную информацию, просто переключив этот бит.

В следующих статьях мы рассмотрим подробности исправления ошибок на базе CRC.

Источники:

https://radioprog. ru/post/531

| Обноружение ошибок | Обноружение ошибок |  |

||||

| Исправление ошибок | Исправление ошибок |  |

||||

| Коррекция ошибок | Коррекция ошибок |  |

||||

| Назад | Назад |  |

||||

Методы обнаружения ошибок

В обычном равномерном непомехоустойчивом коде число разрядов n в кодовых

комбинациях определяется числом сообщений и основанием кода.

Коды, у которых все кодовые комбинации разрешены, называются простыми или

равнодоступными и являются полностью безызбыточными. Безызбыточные коды обладают

большой «чувствительностью» к помехам. Внесение избыточности при использовании

помехоустойчивых кодов связано с увеличением n – числа разрядов кодовой комбинации. Таким

образом, все множество

подмножество разрешенных комбинаций, обладающих определенными признаками, и

подмножество запрещенных комбинаций, этими признаками не обладающих.

Помехоустойчивый код отличается от обычного кода тем, что в канал передаются не все

кодовые комбинации N, которые можно сформировать из имеющегося числа разрядов n, а только

их часть Nk , которая составляет подмножество разрешенных комбинаций. Если при приеме

выясняется, что кодовая комбинация принадлежит к запрещенным, то это свидетельствует о

наличии ошибок в комбинации, т.е. таким образом решается задача обнаружения ошибок. При

этом принятая комбинация не декодируется (не принимается решение о переданном

сообщении). В связи с этим помехоустойчивые коды называют корректирующими кодами.

Корректирующие свойства избыточных кодов зависят от правила их построения, определяющего

структуру кода, и параметров кода (длительности символов, числа разрядов, избыточности и т. п.).

Первые работы по корректирующим кодам принадлежат Хеммингу, который ввел понятие

минимального кодового расстояния dmin и предложил код, позволяющий однозначно указать ту

позицию в кодовой комбинации, где произошла ошибка. К информационным элементам k в коде

Хемминга добавляется m проверочных элементов для автоматического определения

местоположения ошибочного символа. Таким образом, общая длина кодовой комбинации

составляет: n = k + m.

Метричное представление n,k-кодов

В настоящее время наибольшее внимание с точки зрения технических приложений

уделяется двоичным блочным корректирующим кодам. При использовании блочных кодов

цифровая информация передается в виде отдельных кодовых комбинаций (блоков) равной

длины. Кодирование и декодирование каждого блока осуществляется независимо друг от друга.

Почти все блочные коды относятся к разделимым кодам, кодовые комбинации которых

состоят из двух частей: информационной и проверочной. При общем числе n символов в блоке

число информационных символов равно k, а число проверочных символов:

К основным характеристикам корректирующих кодов относятся:

|

— число разрешенных и запрещенных кодовых комбинаций; |

Для блочных двоичных кодов, с числом символов в блоках, равным n, общее число

возможных кодовых комбинаций определяется значением

Число разрешенных кодовых комбинаций при наличии k информационных разрядов в

первичном коде:

Очевидно, что число запрещенных комбинаций:

а с учетом отношение будет

где m – число избыточных (проверочных) разрядов в блочном коде.

Избыточностью корректирующего кода называют величину

откуда следует:

Эта величина показывает, какую часть общего числа символов кодовой комбинации

составляют информационные символы. В теории кодирования величину Bk называют

относительной скоростью кода. Если производительность источника информации равна H

символов в секунду, то скорость передачи после кодирования этой информации будет

поскольку в закодированной последовательности из каждых n символов только k символов

являются информационными.

Если число ошибок, которые нужно обнаружить или исправить, значительно, то необходимо

иметь код с большим числом проверочных символов. Чтобы при этом скорость передачи

оставалась достаточно высокой, необходимо в каждом кодовом блоке одновременно

увеличивать как общее число символов, так и число информационных символов.

При этом длительность кодовых блоков будет существенно возрастать, что приведет к

задержке информации при передаче и приеме. Чем сложнее кодирование, тем длительнее

временная задержка информации.

Минимальное кодовое расстояние – dmin. Для того чтобы можно было обнаружить и

исправлять ошибки, разрешенная комбинация должна как можно больше отличаться от

запрещенной. Если ошибки в канале связи действуют независимо, то вероятность преобразования

одной кодовой комбинации в другую будет тем меньше, чем большим числом символов они

различаются.

Если интерпретировать кодовые комбинации как точки в пространстве, то отличие

выражается в близости этих точек, т. е. в расстоянии между ними.

Количество разрядов (символов), которыми отличаются две кодовые комбинации, можно

принять за кодовое расстояние между ними. Для определения этого расстояния нужно сложить

две кодовые комбинации «по модулю 2» и подсчитать число единиц в полученной сумме.

Например, две кодовые комбинации xi = 01011 и xj = 10010 имеют расстояние d(xi,xj) , равное 3,

так как:

Здесь под операцией ⊕ понимается сложение «по модулю 2».

Заметим, что кодовое расстояние d(xi,x0) между комбинацией xi и нулевой x0 = 00…0

называют весом W комбинации xi, т.е. вес xi равен числу «1» в ней.

Расстояние между различными комбинациями некоторого конкретного кода могут

существенно отличаться. Так, в частности, в безызбыточном первичном натуральном коде n = k это

расстояние для различных комбинаций может изменяться от единицы до величины n, равной

разрядности кода. Особую важность для характеристики корректирующих свойств кода имеет

минимальное кодовое расстояние dmin, определяемое при попарном сравнении всех кодовых

комбинаций, которое называют расстоянием Хемминга.

В безызбыточном коде все комбинации являются разрешенными и его минимальное

кодовое расстояние равно единице – dmin=1. Поэтому достаточно исказиться одному символу,

чтобы вместо переданной комбинации была принята другая разрешенная комбинация. Чтобы код

обладал корректирующими свойствами, необходимо ввести в него некоторую избыточность,

которая обеспечивала бы минимальное расстояние между любыми двумя разрешенными

комбинациями не менее двух – dmin ≥ 2..

Минимальное кодовое расстояние является важнейшей характеристикой помехоустойчивых

кодов, указывающей на гарантируемое число обнаруживаемых или исправляемых заданным

кодом ошибок.

Число обнаруживаемых или исправляемых ошибок

При применении двоичных кодов учитывают только дискретные искажения, при которых

единица переходит в нуль («1» → «0») или нуль переходит в единицу («0» → «1»). Переход «1» →

«0» или «0» → «1» только в одном элементе кодовой комбинации называют единичной ошибкой

(единичным искажением). В общем случае под кратностью ошибки подразумевают число

позиций кодовой комбинации, на которых под действием помехи одни символы оказались

замененными на другие. Возможны двукратные (g = 2) и многократные (g > 2) искажения

элементов в кодовой комбинации в пределах 0 ≤ g ≤ n.

Минимальное кодовое расстояние является основным параметром, характеризующим

корректирующие способности данного кода. Если код используется только для обнаружения

ошибок кратностью g0, то необходимо и достаточно, чтобы минимальное кодовое расстояние

было равно dmin ≥ g0 + 1.

В этом случае никакая комбинация из go ошибок не может перевести одну разрешенную

кодовую комбинацию в другую разрешенную. Таким образом, условие обнаружения всех ошибок

кратностью g0 можно записать

Чтобы можно было исправить все ошибки кратностью gu и менее, необходимо иметь

минимальное расстояние, удовлетворяющее условию dmin ≥ 2gu

В этом случае любая кодовая комбинация с числом ошибок gu отличается от каждой

разрешенной комбинации не менее чем в gu+1 позициях. Если условие не выполнено,

возможен случай, когда ошибки кратности g исказят переданную комбинацию так, что она станет

ближе к одной из разрешенных комбинаций, чем к переданной или даже перейдет в другую

разрешенную комбинацию. В соответствии с этим, условие исправления всех ошибок кратностью

не более gи можно записать:

Из и

следует, что если код исправляет все ошибки кратностью gu, то число

ошибок, которые он может обнаружить, равно go = 2gu. Следует отметить, что эти соотношения

устанавливают лишь гарантированное минимальное число обнаруживаемых или

исправляемых ошибок при заданном dmin и не ограничивают возможность обнаружения ошибок

большей кратности. Например, простейший код с проверкой на четность с dmin = 2 позволяет

обнаруживать не только одиночные ошибки, но и любое нечетное число ошибок в пределах go < n.

Корректирующие возможности кодов

Вопрос о минимально необходимой избыточности, при которой код обладает нужными

корректирующими свойствами, является одним из важнейших в теории кодирования. Этот вопрос

до сих пор не получил полного решения. В настоящее время получен лишь ряд верхних и нижних

оценок (границ), которые устанавливают связь между максимально возможным минимальным

расстоянием корректирующего кода и его избыточностью.

Коды Хэмминга

Построение кодов Хемминга базируется на принципе проверки на четность веса W (числа

единичных символов «1») в информационной группе кодового блока.

Поясним идею проверки на четность на примере простейшего корректирующего кода,

который так и называется кодом с проверкой на четность или кодом с проверкой по паритету

(равенству).

В таком коде к кодовым комбинациям безызбыточного первичного двоичного k-разрядного

кода добавляется один дополнительный разряд (символ проверки на четность, называемый

проверочным, или контрольным). Если число символов «1» исходной кодовой комбинации

четное, то в дополнительном разряде формируют контрольный символ «0», а если число

символов «1» нечетное, то в дополнительном разряде формируют символ «1». В результате

общее число символов «1» в любой передаваемой кодовой комбинации всегда будет четным.

Таким образом, правило формирования проверочного символа сводится к следующему:

где i – соответствующий информационный символ («0» или «1»); k – общее их число а, под

операцией ⊕ здесь и далее понимается сложение «по модулю 2». Очевидно, что добавление

дополнительного разряда увеличивает общее число возможных комбинаций вдвое по сравнению

с числом комбинаций исходного первичного кода, а условие четности разделяет все комбинации

на разрешенные и неразрешенные. Код с проверкой на четность позволяет обнаруживать

одиночную ошибку при приеме кодовой комбинации, так как такая ошибка нарушает условие

четности, переводя разрешенную комбинацию в запрещенную.

Критерием правильности принятой комбинации является равенство нулю результата S

суммирования «по модулю 2» всех n символов кода, включая проверочный символ m1. При

наличии одиночной ошибки S принимает значение 1:

— ошибок нет,

— однократная ошибка

Этот код является (k+1,k)-кодом, или (n,n–1)-кодом. Минимальное расстояние кода равно

двум (dmin = 2), и, следовательно, никакие ошибки не могут быть исправлены. Простой код с

проверкой на четность может использоваться только для обнаружения (но не исправления)

однократных ошибок.

Увеличивая число дополнительных проверочных разрядов, и формируя по определенным

правилам проверочные символы m, равные «0» или «1», можно усилить корректирующие

свойства кода так, чтобы он позволял не только обнаруживать, но и исправлять ошибки. На этом и

основано построение кодов Хемминга.

Коды Хемминга позволяют исправлять одиночную ошибку, с помощью непосредственного

описания. Для каждого числа проверочных символов m =3, 4, 5… существует классический код

Хемминга с маркировкой

т.е. (7,4), (15,11) (31,26) …

При других значениях числа информационных символов k получаются так называемые

усеченные (укороченные) коды Хемминга. Так для кода имеющего 5 информационных символов,

потребуется использование корректирующего кода (9,5), являющегося усеченным от

классического кода Хемминга (15,11), так как число символов в этом коде уменьшается

(укорачивается) на 6.

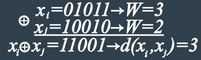

Для примера рассмотрим классический код Хемминга (7,4), который можно сформировать и

описать с помощью кодера, представленного на рис. 1 В простейшем варианте при заданных

четырех информационных символах: i1, i2, i3, i4 (k = 4), будем полагать, что они сгруппированы в

начале кодового слова, хотя это и не обязательно. Дополним эти информационные символы

тремя проверочными символами (m = 3), задавая их следующими равенствами проверки на

четность, которые определяются соответствующими алгоритмами, где знак ⊕ означает

сложение «по модулю 2»: r1 = i1 ⊕ i2 ⊕ i3, r2 = i2 ⊕ i3 ⊕ i4, r3 = i1 ⊕ i2 ⊕ i4.

В соответствии с этим алгоритмом определения значений проверочных символов mi, в табл.

1 выписаны все возможные 16 кодовых слов (7,4)-кода Хемминга.

Таблица 1 Кодовые слова (7,4)-кода Хэмминга

|

k=4 |

m=4 |

|

i1 i2 i3 i4 |

r1 r2 r3 |

|

0 0 0 0 |

0 0 0 |

|

0 0 0 1 |

0 1 1 |

|

0 0 1 0 |

1 1 0 |

|

0 0 1 1 |

1 0 1 |

|

0 1 0 0 |

1 1 1 |

|

0 1 0 1 |

1 0 0 |

|

0 1 1 0 |

0 0 1 |

|

0 1 1 1 |

0 1 0 |

|

1 0 0 0 |

1 0 1 |

|

1 0 0 1 |

1 0 0 |

|

1 0 1 0 |

0 1 1 |

|

1 0 1 1 |

0 0 0 |

|

1 1 0 0 |

0 1 0 |

|

1 1 0 1 |

0 0 1 |

|

1 1 1 0 |

1 0 0 |

|

1 1 1 1 |

1 1 1 |

На рис.1 приведена блок-схема кодера – устройства автоматически кодирующего

информационные разряды в кодовые комбинации в соответствии с табл.1

Рис. 1 Кодер для (7,4)-кода Хемминга

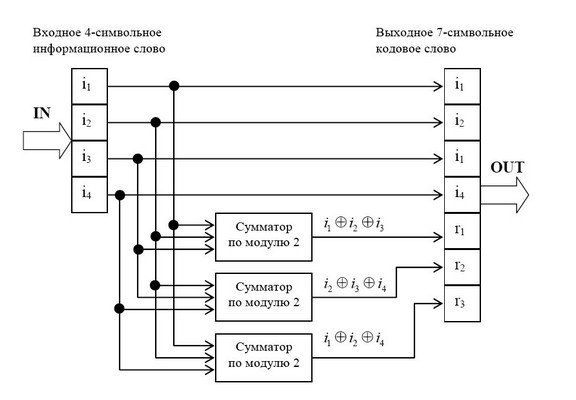

На рис. 1.4 приведена схема декодера для (7,4) – кода Хемминга, на вход которого

поступает кодовое слово

. Апостроф означает, что любой символ слова может

быть искажен помехой в телекоммуникационном канале.

В декодере в режиме исправления ошибок строится последовательность:

Трехсимвольная последовательность (s1, s2, s3) называется синдромом. Термин «синдром»

используется и в медицине, где он обозначает сочетание признаков, характерных для

определенного заболевания. В данном случае синдром S = (s1, s2, s3) представляет собой

сочетание результатов проверки на четность соответствующих символов кодовой группы и

характеризует определенную конфигурацию ошибок (шумовой вектор).

Число возможных синдромов определяется выражением:

При числе проверочных символов m =3 имеется восемь возможных синдромов (23 =

Нулевой синдром (000) указывает на то, что ошибки при приеме отсутствуют или не обнаружены.

Всякому ненулевому синдрому соответствует определенная конфигурация ошибок, которая и

исправляется. Классические коды Хемминга имеют число синдромов, точно равное их

необходимому числу (что позволяет исправить все однократные ошибки в любом информативном

и проверочном символах) и включают один нулевой синдром. Такие коды называются

плотноупакованными.

Усеченные коды являются неплотноупакованными, так как число синдромов у них

превышает необходимое. Так, в коде (9,5) при четырех проверочных символах число синдромов

будет равно 24 =16, в то время как необходимо всего 10. Лишние 6 синдромов свидетельствуют о

неполной упаковке кода (9,5).

Рис. 2 Декодер для (7, 4)-кода Хемминга

Для рассматриваемого кода (7,4) в табл. 2 представлены ненулевые синдромы и

соответствующие конфигурации ошибок.

Таблица 2 Синдромы (7, 4)-кода Хемминга

|

Синдром |

001 |

010 |

011 |

100 |

101 |

110 |

111 |

|

Конфигурация ошибок |

0000001 |

0000010 |

0000100 |

0001000 |

0010000 |

0100000 |

1000000 |

|

Ошибка в символе |

m1 |

m2 |

i4 |

m1 |

i1 |

i3 |

i2 |

Таким образом, (7,4)-код позволяет исправить все одиночные ошибки. Простая проверка

показывает, что каждая из ошибок имеет свой единственный синдром. При этом возможно

создание такого цифрового корректора ошибок (дешифратора синдрома), который по

соответствующему синдрому исправляет соответствующий символ в принятой кодовой группе.

После внесения исправления проверочные символы ri можно на выход декодера (рис. 2) не

выводить. Две или более ошибок превышают возможности корректирующего кода Хемминга, и

декодер будет ошибаться. Это означает, что он будет вносить неправильные исправления и

выдавать искаженные информационные символы.

Идея построения подобного корректирующего кода, естественно, не меняется при

перестановке позиций символов в кодовых словах. Все такие варианты также называются (7,4)-

кодами Хемминга.

Циклические коды

Своим названием эти коды обязаны такому факту, что для них часть комбинаций, либо все

комбинации могут быть получены путем циклическою сдвига одной или нескольких базовых

комбинаций кода.

Построение такого кода основывается на использовании неприводимых многочленов в поле

двоичных чисел. Такие многочлены не могут быть представлены в виде произведения

многочленов низших степеней подобно тому, как простые числа не могут быть представлены

произведением других чисел. Они делятся без остатка только на себя или на единицу.

Для определения неприводимых многочленов раскладывают на простые множители бином

хn -1. Так, для n = 7 это разложение имеет вид:

(x7)=(x-1)(x3+x2)(x3+x-1)

Каждый из полученных множителей разложения может применяться для построения

корректирующего кода.

Неприводимый полином g(x) называют задающим, образующим или порождающим

для корректирующего кода. Длина n (число разрядов) создаваемого кода произвольна.

Кодовая последовательность (комбинация) корректирующего кода состоит из к информационных

разрядов и n — к контрольных (проверочных) разрядов. Степень порождающего полинома

r = n — к равна количеству неинформационных контрольных разрядов.

Если из сделанного выше разложения (при n = 7) взять полипом (х — 1), для которого

r=1, то k=n-r=7-1=6. Соответствующий этому полиному код используется для контроля

на чет/нечет (обнаружение ошибок). Для него минимальное кодовое расстояние D0 = 2

(одна единица от D0 — для исходного двоичного кода, вторая единица — за счет контрольного разряда).

Если же взять полином (x3+x2+1) из указанного разложения, то степень полинома

r=3, а k=n-r=7-3=4.

Контрольным разрядам в комбинации для некоторого кода могут быть четко определено место (номера разрядов).

Тогда код называют систематическим или разделимым. В противном случае код является неразделимым.

Способы построения циклических кодов по заданному полиному.

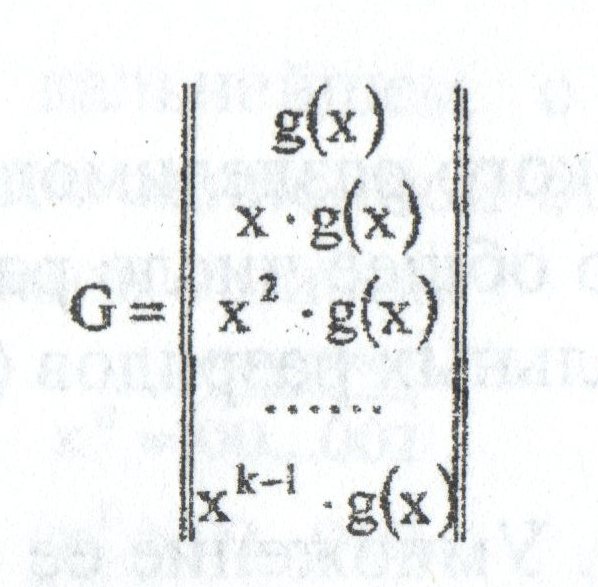

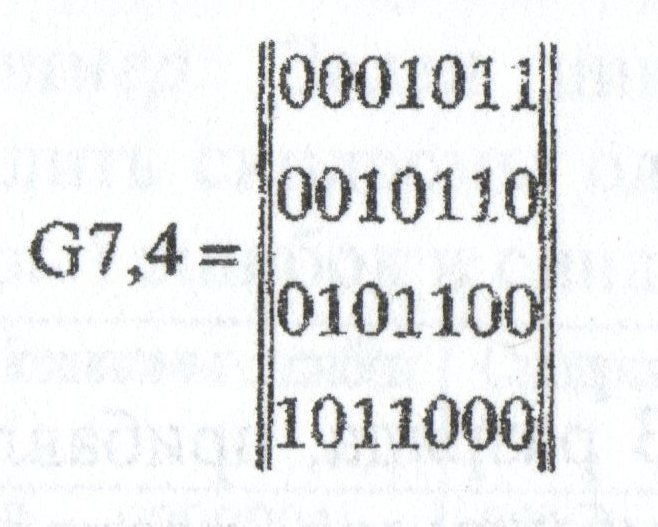

1) На основе порождающей (задающей) матрицы G, которая имеет n столбцов, k строк, то есть параметры которой

связаны с параметрами комбинаций кода. Порождающую матрицу строят, взяв в качестве ее строк порождающий

полином g(x) и (k — 1) его циклических сдвигов:

Пример; Определить порождающую матрицу, если известно, что n=7, k=4, задающий полином g(x)=x3+х+1.

Решение: Кодовая комбинация, соответствующая задающему полиному g(x)=x3+х+1, имеет вид 1011.

Тогда порождающая матрица G7,4 для кода при n=7, к=4 с учетом того, что k-1=3, имеет вид:

Порождающая матрица содержит k разрешенных кодовых комбинаций. Остальные комбинации кода,

количество которых (2k — k) можно определить суммированием по модулю 2 всевозможных сочетаний

строк матрицы Gn,k. Для матрицы, полученной в приведенном выше примере, суммирование по модулю 2

четырех строк 1-2, 1-3, 1-4, 2-3, 2-4, 3-4 дает следующие кодовые комбинации циклического кода:

001110101001111010011011101010011101110100

Другие комбинации искомого корректирующего кода могут быть получены сложением трех комбинаций, например,

из сочетания строк 1-3-4, что дает комбинацию 1111111, а также сложением четырех строк 1-2-3-4, что

дает комбинацию 1101001 и т.д.

Ряд комбинаций искомого кода может быть получено путем дальнейшего циклического сдвига комбинаций

порождающей матрицы, например, 0110001, 1100010, 1000101. Всего для образования искомого циклического

кода требуется 2k=24=16 комбинаций.

2) Умножение исходных двоичных кодовых комбинаций на задающий полином.

Исходными комбинациями являются все k-разрядные двоичные комбинации. Так, например, для исходной

комбинации 1111 (при k = 4) умножение ее на задающий полином g(x)=x3+х+1=1011 дает 1101001.

Полученные на основе двух рассмотренных способов циклические коды не являются разделимыми.

3) Деление на задающий полином.

Для получения разделимого (систематического) циклического кода необходимо разделить многочлен

xn-k*h(x), где h(x) — исходная двоичная комбинация, на задающий полином g(x) и прибавить полученный

остаток от деления к многочлену xn-k*h(x).

Заметим, что умножение исходной комбинации h(x) на xn-k эквивалентно сдвигу h(x) на (n-к) разрядов влево.

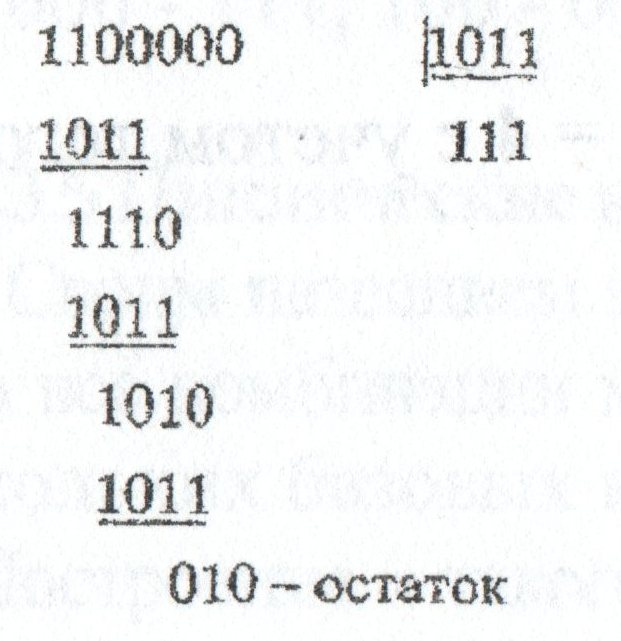

Пример: Требуется определить комбинации циклического разделимого кода, заданного полиномом g(x)=x3+х+1=1011 и

имеющего общее число разрядов 7, число информационных разрядов 4, число контрольных разрядов (n-k)=3.

Решение: Пусть исходная комбинация h(x)=1100. Умножение ее на xn-k=x3=1000 дает

x3*(x3+x2)=1100000, то есть эквивалентно

сдвигу исходной комбинации на 3 разряда влево. Деление комбинации 1100000 на комбинацию 1011, эквивалентно задающему полиному, дает:

Полученный остаток от деления, содержащий xn-k=3 разряда, прибавляем к полиному, в результате чего получаем искомую комбинацию

разделимого циклического кода: 1100010. В ней 4 старших разряда (слева) соответствуют исходной двоичной комбинации, а три младших

разряда являются контрольными.

Следует сделать ряд указаний относительно процедуры деления:

1) При делении задающий полином совмещается старшим разрядом со старшим «единичными разрядом делимого.

2) Вместо вычитания по модулю 2 выполняется эквивалентная ему процедура сложения по модулю 2.

3) Деление продолжается до тех пор, пока степень очередного остатка не будет меньше степени делителя (задающего полинома). При достижении

этого полученный остаток соответствует искомому содержанию контрольных разрядов для данной искомой двоичной комбинации.

Для проверки правильности выполнения процедуры определения комбинации циклического кода необходимо разделить полученную комб1шацию на задающий полином с

учетом сделанных выше замечаний. Получение нулевого остатка от такого деления свидетельствует о правильности определения комбинации.

Логический код 4В/5В

Логический код 4В/5В заменяет исходные символы длиной в 4 бита на символы длиной в 5 бит. Так как результирующие символы содержат избыточные биты, то

общее количество битовых комбинаций в них больше, чем в исходных. Таким образом, пяти-битовая схема дает 32 (25) двухразрядных буквенно-цифровых символа,

имеющих значение в десятичном коде от 00 до 31. В то время как исходные данные могут содержать только четыре бита или 16 (24) символов.

Поэтому в результирующем коде можно подобрать 16 таких комбинаций, которые не содержат большого количества нулей, а остальные считать запрещенными кодами

(code violation). В этом случае длинные последовательности нулей прерываются, и код становится самосинхронизирующимся для любых передаваемых данных.

Исчезает также постоянная составляющая, а значит, еще более сужается спектр сигнала. Но этот метод снижает полезную пропускную способность линии,

так как избыточные единицы пользовательской информации не несут, и только «занимают эфирное время». Избыточные коды позволяют приемнику распознавать

искаженные биты. Если приемник принимает запрещенный код, значит, на линии произошло искажение сигнала.

Итак, рассмотрим работу логического кода 4В/5В. Преобразованный сигнал имеет 16 значений для передачи информации и 16 избыточных значений. В декодере

приемника пять битов расшифровываются как информационные и служебные сигналы.

Для служебных сигналов отведены девять символов, семь символов — исключены.

Исключены комбинации, имеющие более трех нулей (01 — 00001, 02 — 00010, 03 — 00011, 08 — 01000, 16 — 10000). Такие сигналы интерпретируются символом

V и командой приемника VIOLATION — сбой. Команда означает наличие ошибки из-за высокого уровня помех или сбоя передатчика. Единственная

комбинация из пяти нулей (00 — 00000) относится к служебным сигналам, означает символ Q и имеет статус QUIET — отсутствие сигнала в линии.

Такое кодирование данных решает две задачи — синхронизации и улучшения помехоустойчивости. Синхронизация происходит за счет исключения

последовательности более трех нулей, а высокая помехоустойчивость достигается приемником данных на пяти-битовом интервале.

Цена за эти достоинства при таком способе кодирования данных — снижение скорости передачи полезной информации.

К примеру, В результате добавления одного избыточного бита на четыре информационных, эффективность использования полосы

частот в протоколах с кодом MLT-3 и кодированием данных 4B/5B уменьшается соответственно на 25%.

Схема кодирования 4В/5В представлена в таблице.

|

Двоичный код 4В |

Результирующий код 5В |

|

0 0 0 0 |

1 1 1 1 0 |

|

0 0 0 1 |

0 1 0 0 1 |

|

0 0 1 0 |

1 0 1 0 0 |

|

0 0 1 1 |

1 0 1 0 1 |

|

0 1 0 0 |

0 1 0 1 0 |

|

0 1 0 1 |

0 1 0 1 1 |

|

0 1 1 0 |

0 1 1 1 0 |

|

0 1 1 1 |

0 1 1 1 1 |

|

1 0 0 0 |

1 0 0 1 0 |

|

1 0 0 1 |

1 0 0 1 1 |

|

1 0 1 0 |

1 0 1 1 0 |

|

1 0 1 1 |

1 0 1 1 1 |

|

1 1 0 0 |

1 1 0 1 0 |

|

1 1 0 1 |

1 1 0 1 1 |

|

1 1 1 0 |

1 1 1 0 0 |

|

1 1 1 1 |

1 1 1 0 1 |

Итак, соответственно этой таблице формируется код 4В/5В, затем передается по линии с помощью физического кодирования по

одному из методов потенциального кодирования, чувствительному только к длинным последовательностям нулей — например, в помощью

цифрового кода NRZI.

Символы кода 4В/5В длиной 5 бит гарантируют, что при любом их сочетании на линии не могут встретиться более трех нулей подряд.

Буква ^ В в названии кода означает, что элементарный сигнал имеет 2 состояния — от английского binary — двоичный. Имеются

также коды и с тремя состояниями сигнала, например, в коде 8В/6Т для кодирования 8 бит исходной информации используется

код из 6 сигналов, каждый из которых имеет три состояния. Избыточность кода 8В/6Т выше, чем кода 4В/5В, так как на 256

исходных кодов приходится 36=729 результирующих символов.

Как мы говорили, логическое кодирование происходит до физического, следовательно, его осуществляют оборудование канального

уровня сети: сетевые адаптеры и интерфейсные блоки коммутаторов и маршрутизаторов. Поскольку, как вы сами убедились,

использование таблицы перекодировки является очень простой операцией, поэтому метод логического кодирования избыточными

кодами не усложняет функциональные требования к этому оборудованию.

Единственное требование — для обеспечения заданной пропускной способности линии передатчик, использующий избыточный код,

должен работать с повышенной тактовой частотой. Так, для передачи кодов 4В/5В со скоростью 100 Мб/с передатчик должен

работать с тактовой частотой 125 МГц. При этом спектр сигнала на линии расширяется по сравнению со случаем, когда по

линии передается чистый, не избыточный код. Тем не менее, спектр избыточного потенциального кода оказывается уже

спектра манчестерского кода, что оправдывает дополнительный этап логического кодирования, а также работу приемника

и передатчика на повышенной тактовой частоте.

В основном для локальных сетей проще, надежней, качественней, быстрей — использовать логическое кодирование данных

с помощью избыточных кодов, которое устранит длительные последовательности нулей и обеспечит синхронизацию

сигнала, потом на физическом уровне использовать для передачи быстрый цифровой код NRZI, нежели без предварительного

логического кодирования использовать для передачи данных медленный, но самосинхронизирующийся манчестерский код.

Например, для передачи данных по линии с пропускной способностью 100М бит/с и полосой пропускания 100 МГц,

кодом NRZI необходимы частоты 25 — 50 МГц, это без кодирования 4В/5В. А если применить для NRZI еще и

кодирование 4В/5В, то теперь полоса частот расширится от 31,25 до 62,5 МГц. Но тем не менее, этот диапазон

еще «влазит» в полосу пропускания линии. А для манчестерского кода без применения всякого дополнительного

кодирования необходимы частоты от 50 до 100 МГц, и это частоты основного сигнала, но они уже не будут пропускаться

линией на 100 МГц.

Скрэмблирование

Другой метод логического кодирования основан на предварительном «перемешивании» исходной информации таким

образом, чтобы вероятность появления единиц и нулей на линии становилась близкой.

Устройства, или блоки, выполняющие такую операцию, называются скрэмблерами (scramble — свалка, беспорядочная сборка) .

При скремблировании данные перемешиваються по определенному алгоритму и приемник, получив двоичные данные, передает

их на дескрэмблер, который восстанавливает исходную последовательность бит.

Избыточные биты при этом по линии не передаются.

Суть скремблирования заключается просто в побитном изменении проходящего через систему потока данных. Практически

единственной операцией, используемой в скремблерах является XOR — «побитное исключающее ИЛИ», или еще говорят —

сложение по модулю 2. При сложении двух единиц исключающим ИЛИ отбрасывается старшая единица и результат записывается — 0.

Метод скрэмблирования очень прост. Сначала придумывают скрэмблер. Другими словами придумывают по какому соотношению

перемешивать биты в исходной последовательности с помощью «исключающего ИЛИ». Затем согласно этому соотношению из текущей

последовательности бит выбираются значения определенных разрядов и складываются по XOR между собой. При этом все разряды

сдвигаются на 1 бит, а только что полученное значение («0» или «1») помещается в освободившийся самый младший разряд.

Значение, находившееся в самом старшем разряде до сдвига, добавляется в кодирующую последовательность, становясь очередным

ее битом. Затем эта последовательность выдается в линию, где с помощью методов физического кодирования передается к

узлу-получателю, на входе которого эта последовательность дескрэмблируется на основе обратного отношения.

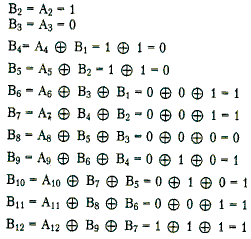

Например, скрэмблер может реализовывать следующее соотношение:

где Bi — двоичная цифра результирующего кода, полученная на i-м такте работы скрэмблера, Ai — двоичная цифра исходного

кода, поступающая на i-м такте на вход скрэмблера, Bi-3 и Bi-5 — двоичные цифры результирующего кода, полученные на

предыдущих тактах работы скрэмблера, соответственно на 3 и на 5 тактов ранее текущего такта, ⊕ — операция исключающего

ИЛИ (сложение по модулю 2).

Теперь давайте, определим закодированную последовательность, например, для такой исходной последовательности 110110000001.

Скрэмблер, определенный выше даст следующий результирующий код:

B1=А1=1 (первые три цифры результирующего кода будут совпадать с исходным, так как еще нет нужных предыдущих цифр)

Таким образом, на выходе скрэмблера появится последовательность 110001101111. В которой нет последовательности из шести нулей, п

рисутствовавшей в исходном коде.

После получения результирующей последовательности приемник передает ее дескрэмблеру, который восстанавливает исходную

последовательность на основании обратного соотношения.

Существуют другие различные алгоритмы скрэмблирования, они отличаются количеством слагаемых, дающих цифру

результирующего кода, и сдвигом между слагаемыми.

Главная проблема кодирования на основе скремблеров — синхронизация передающего (кодирующего) и принимающего

(декодирующего) устройств. При пропуске или ошибочном вставлении хотя бы одного бита вся передаваемая информация

необратимо теряется. Поэтому, в системах кодирования на основе скремблеров очень большое внимание уделяется методам синхронизации.

На практике для этих целей обычно применяется комбинация двух методов:

а) добавление в поток информации синхронизирующих битов, заранее известных приемной стороне, что позволяет ей при ненахождении

такого бита активно начать поиск синхронизации с отправителем,

б) использование высокоточных генераторов временных импульсов, что позволяет в моменты потери синхронизации производить

декодирование принимаемых битов информации «по памяти» без синхронизации.

Существуют и более простые методы борьбы с последовательностями единиц, также относимые к классу скрэмблирования.

Для улучшения кода ^ Bipolar AMI используются два метода, основанные на искусственном искажении последовательности нулей запрещенными символами.

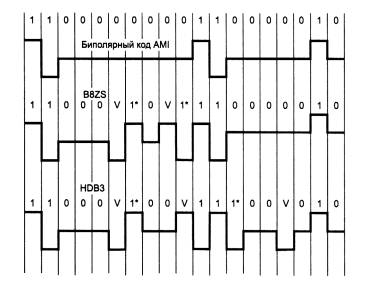

Рис. 3 Коды B8ZS и HDB3

На этом рисунке показано использование метода ^ B8ZS (Bipolar with 8-Zeros Substitution) и метода HDB3 (High-Density Bipolar 3-Zeros) для корректировки

кода AMI. Исходный код состоит из двух длинных последовательностей нулей (8- в первом случае и 5 во втором).

Код B8ZS исправляет только последовательности, состоящие из 8 нулей. Для этого он после первых трех нулей вместо оставшихся пяти нулей вставляет пять

цифр: V-1*-0-V-1*. V здесь обозначает сигнал единицы, запрещенной для данного такта полярности, то есть сигнал, не изменяющий полярность предыдущей

единицы, 1* — сигнал единицы корректной полярности, а знак звездочки отмечает тот факт, что в исходном коде в этом такте была не единица, а ноль. В

результате на 8 тактах приемник наблюдает 2 искажения — очень маловероятно, что это случилось из-за шума на линии или других сбоев передачи. Поэтому

приемник считает такие нарушения кодировкой 8 последовательных нулей и после приема заменяет их на исходные 8 нулей.

Код B8ZS построен так, что его постоянная составляющая равна нулю при любых последовательностях двоичных цифр.

Код HDB3 исправляет любые 4 подряд идущих нуля в исходной последовательности. Правила формирования кода HDB3 более сложные, чем кода B8ZS.

Каждые четыре нуля заменяются четырьмя сигналами, в которых имеется один сигнал V. Для подавления постоянной составляющей полярность сигнала

V чередуется при последовательных заменах.

Кроме того, для замены используются два образца четырехтактовых кодов. Если перед заменой исходный код содержал нечетное число единиц, то

используется последовательность 000V, а если число единиц было четным — последовательность 1*00V.

Таким образом, применение логическое кодирование совместно с потенциальным кодированием дает следующие преимущества:

Улучшенные потенциальные коды обладают достаточно узкой полосой пропускания для любых последовательностей единиц и нулей,

которые встречаются в передаваемых данных. В результате коды, полученные из потенциального путем логического кодирования,

обладают более узким спектром, чем манчестерский, даже при повышенной тактовой частоте.

Линейные блочные коды

При передаче информации по каналам связи возможны ошибки вследствие помех и искажений сигналов. Для обнаружения и

исправления возникающих ошибок используются помехоустойчивые коды. Упрощенная схема системы передачи информации

при помехоустойчивом кодировании показана на рис. 4

Кодер служит для преобразования поступающей от источника сообщений последовательности из k информационных

символов в последовательность из n cимволов кодовых комбинаций (или кодовых слов). Совокупность кодовых слов образует код.

Множество символов, из которых составляется кодовое слово, называется алфавитом кода, а число различных символов в

алфавите – основанием кода. В дальнейшем вследствие их простоты и наибольшего распространения рассматриваются главным

образом двоичные коды, алфавит которых содержит два символа: 0 и 1.

Рис. 4 Система передачи дискретных сообщений

Правило, по которому информационной последовательности сопоставляется кодовое слово, называется правилом кодирования.

Если при кодировании каждый раз формируется блок А из k информационных символов, превращаемый затем в n-символьную

кодовую комбинацию S, то код называется блочным. При другом способе кодирования информационная последовательность на

блоки не разбивается, и код называется непрерывным.

С математической точки зрения кодер осуществляет отображение множества из 2k элементов (двоичных информационных

последовательностей) в множество, состоящее из 2n элементов (двоичных последовательностей длины n). Для практики

интересны такие отображения, в результате которых получаются коды, обладающие способностью исправлять часть ошибок

и допускающие простую техническую реализацию кодирующих и декодирующих устройств.

Дискретный канал связи – это совокупность технических средств вместе со средой распространения радиосигналов, включенных

между кодером и декодером для передачи сигналов, принимающих конечное число разных видов. Для описания реальных каналов

предложено много математических моделей, с разной степенью детализации отражающих реальные процессы. Ограничимся рассмотрением

простейшей модели двоичного канала, входные и выходные сигналы которого могут принимать значения 0 и 1.

Наиболее распространено предположение о действии в канале аддитивной помехи. Пусть S=(s1,s2,…,sn)

и Y=(y1,y2,…,yn) соответственно входная и выходная последовательности двоичных символов.

Помехой или вектором ошибки называется последовательность из n символов E=(e1,e2,…,en), которую

надо поразрядно сложить с переданной последовательностью, чтобы получить принятую:

Y=S+E

Таким образом, компонента вектора ошибки ei=0 указывает на то, что 2-й символ принят правильно (yi=si),

а компонента ei=1 указывает на ошибку при приеме (yi≠si).Поэтому важной характеристикой вектора ошибки

является число q ненулевых компонентов, которое называется весом или кратностью ошибки. Кратность ошибки – дискретная случайная величина,

принимающая целочисленные значения от 0 до n.

Классификация двоичных каналов ведется по виду распределения случайного вектора E. Основные результаты теории кодирования получены в

предположении, что вероятность ошибки в одном символе не зависит ни от его номера в последовательности, ни от его значения. Такой

канал называется стационарным и симметричным. В этом канале передаваемые символы искажаются с одинаковой вероятностью

P, т.е. P(ei=1)=P, i=1,2,…,n.

Для симметричного стационарного канала распределение вероятностей векторов ошибки кратности q является биноминальным:

P(Ei)=Pq(1-P)n-q

которая показывает, что при P<0,5 вероятность β2=αj является убывающей функцией q,

т.е. в симметричном стационарном канале более вероятны ошибки меньшей кратности. Этот важный факт используется при построении

помехоустойчивых кодов, т.к. позволяет обосновать тактику обнаружения и исправления в первую очередь ошибок малой кратности.

Конечно, для других моделей канала такая тактика может и не быть оптимальной.

Декодирующее устройство (декодер) предназначено оценить по принятой последовательности Y=(y1,y2,…,yn)

значения информационных символов A‘=(a‘1,a‘2,…,a‘k,).

Из-за действия помех возможны неправильные решения. Процедура декодирования включает решение двух задач: оценивание переданного кодового

слова и формирование оценок информационных символов.

Вторая задача решается относительно просто. При наиболее часто используемых систематических кодах, кодовые слова которых содержат информационные

символы на известных позициях, все сводится к простому их стробированию. Очевидно также, что расположение информационных символов внутри кодового

слова не имеет существенного значения. Удобно считать, что они занимают первые k позиций кодового слова.

Наибольшую трудность представляет первая задача декодирования. При равновероятных информационных последовательностях ее оптимальное решение

дает метод максимального правдоподобия. Функция правдоподобия как вероятность получения данного вектора Y при передаче кодовых слов

Si, i=1,2,…,2k на основании Y=S+E определяется вероятностями появления векторов ошибок:

P(Y/Si)=P(Ei)=Pqi(1-P)n-qi

где qi – вес вектора Ei=Y+Si

Очевидно, вероятность P(Y/Si) максимальна при минимальном qi. На основании принципа максимального правдоподобия оценкой S‘ является кодовое слово,

искажение которого для превращения его в принятое слово Y имеет минимальный вес, т. е. в симметричном канале является наиболее вероятным (НВ):

S‘=Y+EHB

Если несколько векторов ошибок Ei имеют равные минимальные веса, то наивероятнейшая ошибка EHB определяется случайным выбором среди них.

В качестве расстояния между двумя кодовыми комбинациями принимают так называемое расстояние Хэмминга, которое численно равно количеству символов, в которых одна

комбинация отлична от другой, т.е. весу (числу ненулевых компонентов) разностного вектора. Расстояние Хэмминга между принятой последовательностью Y и всеми

возможными кодовыми словами 5, есть функция весов векторов ошибок Ei:

Поэтому декодирование по минимуму расстояния, когда в качестве оценки берется слово, ближайшее к принятой

последовательности, является декодированием по максимуму правдоподобия.

Таким образом, оптимальная процедура декодирования для симметричного канала может быть описана следующей последовательностью операций. По принятому

вектору Y определяется вектор ошибки с минимальным весом EHB, который затем вычитается (в двоичном канале — складывается по модулю 2) из Y:

Y→EHB→S‘=Y+EHB

Наиболее трудоемкой операцией в этой схеме является определение наи-вероятнейшего вектора ошибки, сложность которой

существенно возрастает при увеличении длины кодовых комбинаций. Правила кодирования, которые нацелены на упрощение

процедур декодирования, предполагают придание всем кодовым словам технически легко проверяемых признаков.

Широко распространены линейные коды, называемые так потому, что их кодовые слова образуют линейное

подпространство над конечным полем. Для двоичных кодов естественно использовать поле характеристики p=2.

Принадлежность принятой комбинации Y известному подпространству является тем признаком, по которому

выносится решение об отсутствии ошибок (EHB=0).

Так как по данному коду все пространство последовательностей длины n разбивается на смежные классы,

то для каждого смежного класса можно заранее определить вектор ошибки минимального веса,

называемый лидером смежного класса. Тогда задача декодера состоит в определении номера смежного класса,

которому принадлежит Y, и формировании лидера этого класса.

To clean up transmission errors introduced by Earth’s atmosphere (left), Goddard scientists applied Reed–Solomon error correction (right), which is commonly used in CDs and DVDs. Typical errors include missing pixels (white) and false signals (black). The white stripe indicates a brief period when transmission was interrupted.

In information theory and coding theory with applications in computer science and telecommunication, error detection and correction (EDAC) or error control are techniques that enable reliable delivery of digital data over unreliable communication channels. Many communication channels are subject to channel noise, and thus errors may be introduced during transmission from the source to a receiver. Error detection techniques allow detecting such errors, while error correction enables reconstruction of the original data in many cases.

Definitions[edit]

Error detection is the detection of errors caused by noise or other impairments during transmission from the transmitter to the receiver.

Error correction is the detection of errors and reconstruction of the original, error-free data.

History[edit]

In classical antiquity, copyists of the Hebrew Bible were paid for their work according to the number of stichs (lines of verse). As the prose books of the Bible were hardly ever written in stichs, the copyists, in order to estimate the amount of work, had to count the letters.[1] This also helped ensure accuracy in the transmission of the text with the production of subsequent copies.[2][3] Between the 7th and 10th centuries CE a group of Jewish scribes formalized and expanded this to create the Numerical Masorah to ensure accurate reproduction of the sacred text. It included counts of the number of words in a line, section, book and groups of books, noting the middle stich of a book, word use statistics, and commentary.[1] Standards became such that a deviation in even a single letter in a Torah scroll was considered unacceptable.[4] The effectiveness of their error correction method was verified by the accuracy of copying through the centuries demonstrated by discovery of the Dead Sea Scrolls in 1947–1956, dating from c. 150 BCE-75 CE.[5]

The modern development of error correction codes is credited to Richard Hamming in 1947.[6] A description of Hamming’s code appeared in Claude Shannon’s A Mathematical Theory of Communication[7] and was quickly generalized by Marcel J. E. Golay.[8]

Principles[edit]

All error-detection and correction schemes add some redundancy (i.e., some extra data) to a message, which receivers can use to check consistency of the delivered message and to recover data that has been determined to be corrupted. Error detection and correction schemes can be either systematic or non-systematic. In a systematic scheme, the transmitter sends the original (error-free) data and attaches a fixed number of check bits (or parity data), which are derived from the data bits by some encoding algorithm. If error detection is required, a receiver can simply apply the same algorithm to the received data bits and compare its output with the received check bits; if the values do not match, an error has occurred at some point during the transmission. If error correction is required, a receiver can apply the decoding algorithm to the received data bits and the received check bits to recover the original error-free data. In a system that uses a non-systematic code, the original message is transformed into an encoded message carrying the same information and that has at least as many bits as the original message.

Good error control performance requires the scheme to be selected based on the characteristics of the communication channel. Common channel models include memoryless models where errors occur randomly and with a certain probability, and dynamic models where errors occur primarily in bursts. Consequently, error-detecting and correcting codes can be generally distinguished between random-error-detecting/correcting and burst-error-detecting/correcting. Some codes can also be suitable for a mixture of random errors and burst errors.

If the channel characteristics cannot be determined, or are highly variable, an error-detection scheme may be combined with a system for retransmissions of erroneous data. This is known as automatic repeat request (ARQ), and is most notably used in the Internet. An alternate approach for error control is hybrid automatic repeat request (HARQ), which is a combination of ARQ and error-correction coding.

Types of error correction[edit]

There are three major types of error correction:[9]

Automatic repeat request[edit]

Automatic repeat request (ARQ) is an error control method for data transmission that makes use of error-detection codes, acknowledgment and/or negative acknowledgment messages, and timeouts to achieve reliable data transmission. An acknowledgment is a message sent by the receiver to indicate that it has correctly received a data frame.

Usually, when the transmitter does not receive the acknowledgment before the timeout occurs (i.e., within a reasonable amount of time after sending the data frame), it retransmits the frame until it is either correctly received or the error persists beyond a predetermined number of retransmissions.

Three types of ARQ protocols are Stop-and-wait ARQ, Go-Back-N ARQ, and Selective Repeat ARQ.

ARQ is appropriate if the communication channel has varying or unknown capacity, such as is the case on the Internet. However, ARQ requires the availability of a back channel, results in possibly increased latency due to retransmissions, and requires the maintenance of buffers and timers for retransmissions, which in the case of network congestion can put a strain on the server and overall network capacity.[10]

For example, ARQ is used on shortwave radio data links in the form of ARQ-E, or combined with multiplexing as ARQ-M.

Forward error correction[edit]

Forward error correction (FEC) is a process of adding redundant data such as an error-correcting code (ECC) to a message so that it can be recovered by a receiver even when a number of errors (up to the capability of the code being used) are introduced, either during the process of transmission or on storage. Since the receiver does not have to ask the sender for retransmission of the data, a backchannel is not required in forward error correction. Error-correcting codes are used in lower-layer communication such as cellular network, high-speed fiber-optic communication and Wi-Fi,[11][12] as well as for reliable storage in media such as flash memory, hard disk and RAM.[13]

Error-correcting codes are usually distinguished between convolutional codes and block codes:

- Convolutional codes are processed on a bit-by-bit basis. They are particularly suitable for implementation in hardware, and the Viterbi decoder allows optimal decoding.

- Block codes are processed on a block-by-block basis. Early examples of block codes are repetition codes, Hamming codes and multidimensional parity-check codes. They were followed by a number of efficient codes, Reed–Solomon codes being the most notable due to their current widespread use. Turbo codes and low-density parity-check codes (LDPC) are relatively new constructions that can provide almost optimal efficiency.

Shannon’s theorem is an important theorem in forward error correction, and describes the maximum information rate at which reliable communication is possible over a channel that has a certain error probability or signal-to-noise ratio (SNR). This strict upper limit is expressed in terms of the channel capacity. More specifically, the theorem says that there exist codes such that with increasing encoding length the probability of error on a discrete memoryless channel can be made arbitrarily small, provided that the code rate is smaller than the channel capacity. The code rate is defined as the fraction k/n of k source symbols and n encoded symbols.

The actual maximum code rate allowed depends on the error-correcting code used, and may be lower. This is because Shannon’s proof was only of existential nature, and did not show how to construct codes that are both optimal and have efficient encoding and decoding algorithms.

Hybrid schemes[edit]

Hybrid ARQ is a combination of ARQ and forward error correction. There are two basic approaches:[10]

- Messages are always transmitted with FEC parity data (and error-detection redundancy). A receiver decodes a message using the parity information and requests retransmission using ARQ only if the parity data was not sufficient for successful decoding (identified through a failed integrity check).

- Messages are transmitted without parity data (only with error-detection information). If a receiver detects an error, it requests FEC information from the transmitter using ARQ and uses it to reconstruct the original message.

The latter approach is particularly attractive on an erasure channel when using a rateless erasure code.

Types of error detection[edit]

Error detection is most commonly realized using a suitable hash function (or specifically, a checksum, cyclic redundancy check or other algorithm). A hash function adds a fixed-length tag to a message, which enables receivers to verify the delivered message by recomputing the tag and comparing it with the one provided.

There exists a vast variety of different hash function designs. However, some are of particularly widespread use because of either their simplicity or their suitability for detecting certain kinds of errors (e.g., the cyclic redundancy check’s performance in detecting burst errors).

Minimum distance coding[edit]

A random-error-correcting code based on minimum distance coding can provide a strict guarantee on the number of detectable errors, but it may not protect against a preimage attack.

Repetition codes[edit]

A repetition code is a coding scheme that repeats the bits across a channel to achieve error-free communication. Given a stream of data to be transmitted, the data are divided into blocks of bits. Each block is transmitted some predetermined number of times. For example, to send the bit pattern 1011, the four-bit block can be repeated three times, thus producing 1011 1011 1011. If this twelve-bit pattern was received as 1010 1011 1011 – where the first block is unlike the other two – an error has occurred.

A repetition code is very inefficient and can be susceptible to problems if the error occurs in exactly the same place for each group (e.g., 1010 1010 1010 in the previous example would be detected as correct). The advantage of repetition codes is that they are extremely simple, and are in fact used in some transmissions of numbers stations.[14][15]

Parity bit[edit]

A parity bit is a bit that is added to a group of source bits to ensure that the number of set bits (i.e., bits with value 1) in the outcome is even or odd. It is a very simple scheme that can be used to detect single or any other odd number (i.e., three, five, etc.) of errors in the output. An even number of flipped bits will make the parity bit appear correct even though the data is erroneous.

Parity bits added to each word sent are called transverse redundancy checks, while those added at the end of a stream of words are called longitudinal redundancy checks. For example, if each of a series of m-bit words has a parity bit added, showing whether there were an odd or even number of ones in that word, any word with a single error in it will be detected. It will not be known where in the word the error is, however. If, in addition, after each stream of n words a parity sum is sent, each bit of which shows whether there were an odd or even number of ones at that bit-position sent in the most recent group, the exact position of the error can be determined and the error corrected. This method is only guaranteed to be effective, however, if there are no more than 1 error in every group of n words. With more error correction bits, more errors can be detected and in some cases corrected.

There are also other bit-grouping techniques.

Checksum[edit]

A checksum of a message is a modular arithmetic sum of message code words of a fixed word length (e.g., byte values). The sum may be negated by means of a ones’-complement operation prior to transmission to detect unintentional all-zero messages.

Checksum schemes include parity bits, check digits, and longitudinal redundancy checks. Some checksum schemes, such as the Damm algorithm, the Luhn algorithm, and the Verhoeff algorithm, are specifically designed to detect errors commonly introduced by humans in writing down or remembering identification numbers.

Cyclic redundancy check[edit]

A cyclic redundancy check (CRC) is a non-secure hash function designed to detect accidental changes to digital data in computer networks. It is not suitable for detecting maliciously introduced errors. It is characterized by specification of a generator polynomial, which is used as the divisor in a polynomial long division over a finite field, taking the input data as the dividend. The remainder becomes the result.

A CRC has properties that make it well suited for detecting burst errors. CRCs are particularly easy to implement in hardware and are therefore commonly used in computer networks and storage devices such as hard disk drives.

The parity bit can be seen as a special-case 1-bit CRC.

Cryptographic hash function[edit]

The output of a cryptographic hash function, also known as a message digest, can provide strong assurances about data integrity, whether changes of the data are accidental (e.g., due to transmission errors) or maliciously introduced. Any modification to the data will likely be detected through a mismatching hash value. Furthermore, given some hash value, it is typically infeasible to find some input data (other than the one given) that will yield the same hash value. If an attacker can change not only the message but also the hash value, then a keyed hash or message authentication code (MAC) can be used for additional security. Without knowing the key, it is not possible for the attacker to easily or conveniently calculate the correct keyed hash value for a modified message.

Error correction code[edit]

Any error-correcting code can be used for error detection. A code with minimum Hamming distance, d, can detect up to d − 1 errors in a code word. Using minimum-distance-based error-correcting codes for error detection can be suitable if a strict limit on the minimum number of errors to be detected is desired.

Codes with minimum Hamming distance d = 2 are degenerate cases of error-correcting codes and can be used to detect single errors. The parity bit is an example of a single-error-detecting code.

Applications[edit]

Applications that require low latency (such as telephone conversations) cannot use automatic repeat request (ARQ); they must use forward error correction (FEC). By the time an ARQ system discovers an error and re-transmits it, the re-sent data will arrive too late to be usable.

Applications where the transmitter immediately forgets the information as soon as it is sent (such as most television cameras) cannot use ARQ; they must use FEC because when an error occurs, the original data is no longer available.

Applications that use ARQ must have a return channel; applications having no return channel cannot use ARQ.

Applications that require extremely low error rates (such as digital money transfers) must use ARQ due to the possibility of uncorrectable errors with FEC.

Reliability and inspection engineering also make use of the theory of error-correcting codes.[16]

Internet[edit]

In a typical TCP/IP stack, error control is performed at multiple levels:

- Each Ethernet frame uses CRC-32 error detection. Frames with detected errors are discarded by the receiver hardware.

- The IPv4 header contains a checksum protecting the contents of the header. Packets with incorrect checksums are dropped within the network or at the receiver.

- The checksum was omitted from the IPv6 header in order to minimize processing costs in network routing and because current link layer technology is assumed to provide sufficient error detection (see also RFC 3819).

- UDP has an optional checksum covering the payload and addressing information in the UDP and IP headers. Packets with incorrect checksums are discarded by the network stack. The checksum is optional under IPv4, and required under IPv6. When omitted, it is assumed the data-link layer provides the desired level of error protection.

- TCP provides a checksum for protecting the payload and addressing information in the TCP and IP headers. Packets with incorrect checksums are discarded by the network stack and eventually get retransmitted using ARQ, either explicitly (such as through three-way handshake) or implicitly due to a timeout.

Deep-space telecommunications[edit]

The development of error-correction codes was tightly coupled with the history of deep-space missions due to the extreme dilution of signal power over interplanetary distances, and the limited power availability aboard space probes. Whereas early missions sent their data uncoded, starting in 1968, digital error correction was implemented in the form of (sub-optimally decoded) convolutional codes and Reed–Muller codes.[17] The Reed–Muller code was well suited to the noise the spacecraft was subject to (approximately matching a bell curve), and was implemented for the Mariner spacecraft and used on missions between 1969 and 1977.

The Voyager 1 and Voyager 2 missions, which started in 1977, were designed to deliver color imaging and scientific information from Jupiter and Saturn.[18] This resulted in increased coding requirements, and thus, the spacecraft were supported by (optimally Viterbi-decoded) convolutional codes that could be concatenated with an outer Golay (24,12,8) code. The Voyager 2 craft additionally supported an implementation of a Reed–Solomon code. The concatenated Reed–Solomon–Viterbi (RSV) code allowed for very powerful error correction, and enabled the spacecraft’s extended journey to Uranus and Neptune. After ECC system upgrades in 1989, both crafts used V2 RSV coding.

The Consultative Committee for Space Data Systems currently recommends usage of error correction codes with performance similar to the Voyager 2 RSV code as a minimum. Concatenated codes are increasingly falling out of favor with space missions, and are replaced by more powerful codes such as Turbo codes or LDPC codes.

The different kinds of deep space and orbital missions that are conducted suggest that trying to find a one-size-fits-all error correction system will be an ongoing problem. For missions close to Earth, the nature of the noise in the communication channel is different from that which a spacecraft on an interplanetary mission experiences. Additionally, as a spacecraft increases its distance from Earth, the problem of correcting for noise becomes more difficult.

Satellite broadcasting[edit]

The demand for satellite transponder bandwidth continues to grow, fueled by the desire to deliver television (including new channels and high-definition television) and IP data. Transponder availability and bandwidth constraints have limited this growth. Transponder capacity is determined by the selected modulation scheme and the proportion of capacity consumed by FEC.

Data storage[edit]